RouteLLM: Разработка сбалансированной системы маршрутизации для Large Language Models (LLM)

Крупные языковые модели (LLM) имеют впечатляющие возможности, но их развертывание в прикладных задачах часто сталкивается с проблемой сбалансирования качества ответов и затрат. Система маршрутизации RouteLLM от исследователей UC Berkeley, Anyscale и Canva предлагает открытую платформу, способную эффективно балансировать стоимость и производительность для решения этой проблемы.

Основные проблемы маршрутизации LLM

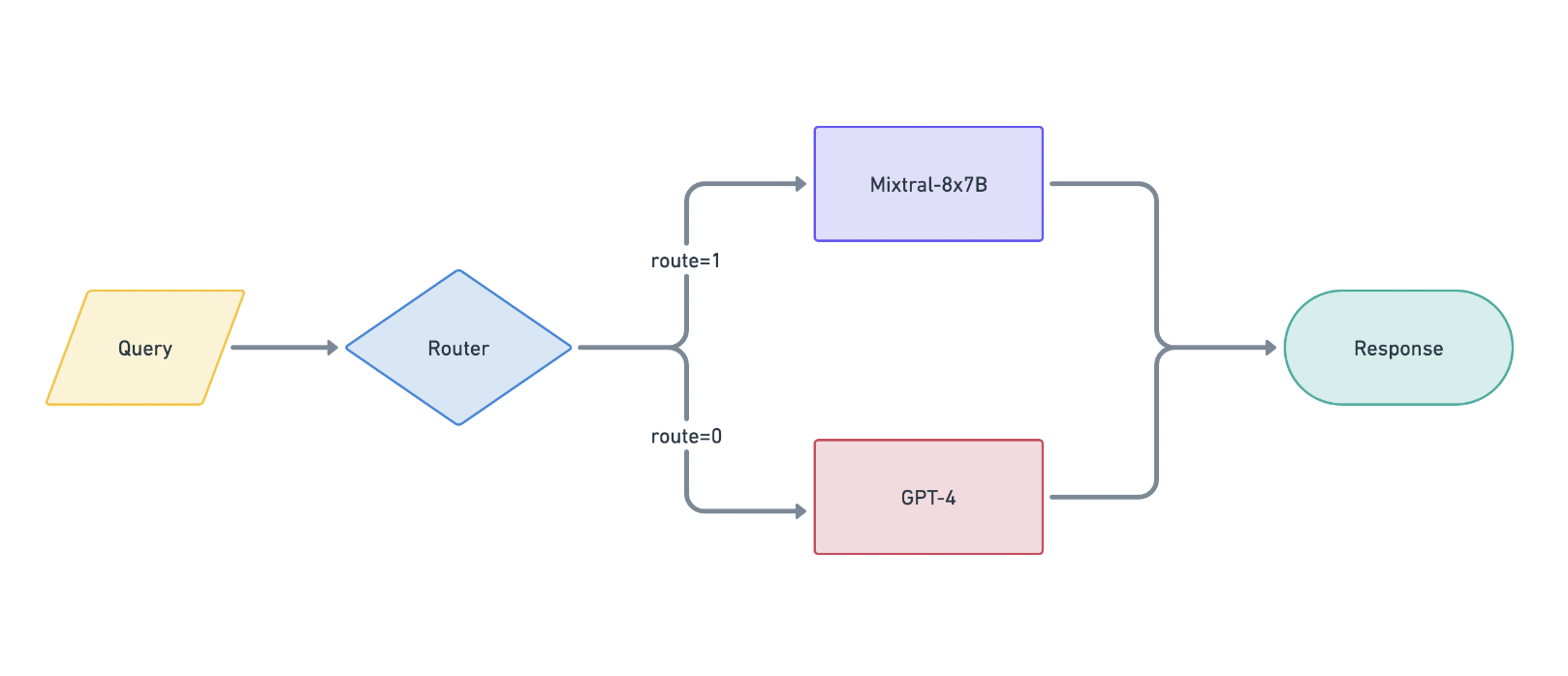

Система маршрутизации LLM должна определять, какая модель должна обрабатывать каждый запрос, чтобы минимизировать затраты, сохраняя при этом качество ответов. RouteLLM решает эту проблему, используя данные предпочтений для обучения своих маршрутизаторов, позволяя системе определять, какие запросы могут обрабатываться менее мощными моделями, а какие требуют более мощных.

Методика и фреймворк

RouteLLM формализует проблему маршрутизации LLM и исследует методы улучшения производительности маршрутизаторов. Фреймворк использует публичные данные из Chatbot Arena и включает новые методы обучения. Были обучены четыре различных маршрутизатора, каждый из которых решает задачу по-своему.

Производительность и эффективность затрат

Результаты показали, что маршрутизаторы могут значительно сократить затраты без ухудшения качества. Например, на MT Bench маршрутизатор матричной факторизации достиг 95% производительности GPT-4, совершая лишь 26% вызовов к GPT-4, что привело к снижению затрат на 48% по сравнению с базовым случайным выбором. Расширение обучающих данных при помощи LLM-судьи дало еще большее улучшение производительности. На MMLU лучший маршрутизатор Causal LLM потребовал всего 54% вызовов GPT-4 для достижения производительности в 95% и снизил затраты на 14% по сравнению с базовым случайным выбором.

Сравнение с коммерческими предложениями

RouteLLM сравнивалась с коммерческими системами маршрутизации, такими как Martian и Unify AI, и достигла схожей производительности, при этом была более чем на 40% дешевле. Это подчеркивает эффективность затрат и конкурентное преимущество фреймворка RouteLLM.

Обобщение на другие модели

RouteLLM показала свою универсальность, успешно работая с различными модельными парами, такими как Claude 3 Opus и Llama 3 8B, без повторного обучения, что свидетельствует о способности обучиться общим характеристикам, помогающим различать мощные и слабые модели.

RouteLLM представляет собой масштабируемое и экономически эффективное решение для развертывания LLM, предоставляя высококачественные ответы при значительном снижении затрат.