«`html

Улучшение многошагового рассуждения в больших языковых моделях с помощью ChatLogic

Большие языковые модели (LLM) продемонстрировали замечательные возможности в генерации контента и решении сложных проблем в различных областях. Однако существует проблема в их способности к многошаговому дедуктивному рассуждению. Текущие LLM нуждаются в помощи в этом типе рассуждения из-за особенностей их методов обучения.

Ограничения текущих LLM

Одной из основных проблем текущих LLM является их ограниченная способность к многошаговому дедуктивному рассуждению. Это ограничение происходит из-за обучения моделей на предсказание следующего токена, что не позволяет им применять логические правила или поддерживать глубокое контекстное понимание. В результате эти модели часто нуждаются в помощи для создания согласованных и логически последовательных ответов в задачах, требующих такого рассуждения.

Практические решения

Существующие методы для улучшения способностей LLM в рассуждении включают интеграцию внешних баз данных памяти и применение техник, таких как Recursive Model Training (RMT). Например, GPT-3.5 и GPT-4 могут расширять пределы токенов через инженерные подсказки или технологии, такие как RMT. Однако эти подходы вносят свои сложности, включая возможное внедрение предубеждений из моделей извлечения в LLM, что может повлиять на точность и стабильность моделей. Также остается значительной проблемой обработка ограничений на длинные последовательности в многотурнирных диалогах.

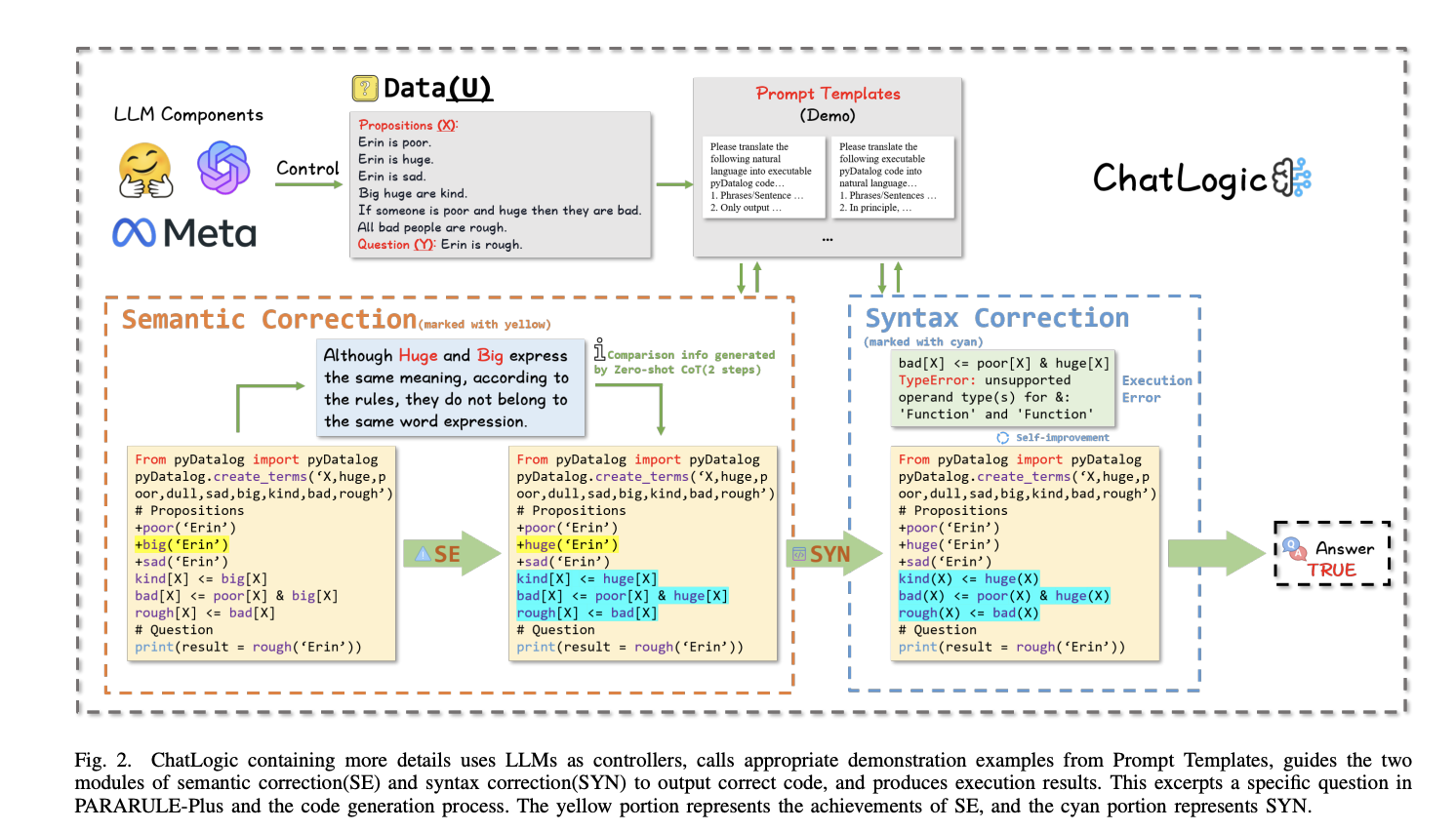

Разработка ChatLogic

Исследователи из Университета Окленда представили ChatLogic, новую платформу, разработанную для расширения LLM логическим движком. Эта платформа направлена на улучшение многошагового дедуктивного рассуждения путем преобразования логических проблем в символьные представления, которые LLM могут обрабатывать. ChatLogic использует ситуативное понимание LLM и интегрирует символьную память для улучшения их способностей к рассуждению.

Эффективность ChatLogic

Экспериментальные результаты показывают, что LLM, интегрированные с ChatLogic, значительно превосходят базовые модели в задачах многошагового рассуждения. Например, на наборе данных PARARULE-Plus GPT-3.5 с ChatLogic достиг точности 0,5275 по сравнению с 0,344 у базовой модели. Аналогично GPT-4 с ChatLogic показал точность 0,73, в то время как базовая модель достигла лишь 0,555. Эти улучшения особенно заметны в сценариях высокой точности, где точность и надежность рассуждения критичны.

Заключение

ChatLogic представляет собой надежное решение для преодоления ограничений многошагового рассуждения текущих LLM. Интеграция логических движков и использование инновационных техник инженерии подсказок значительно улучшили точность и надежность LLM в сложных задачах рассуждения. Это развитие имеет значительный потенциал для различных областей применения, включая обслуживание клиентов, здравоохранение и образование, где точные и логические ответы критичны.

«`