Эффективное тонкое настройка моделей языковых моделей с Expert-Specialized Fine-Tuning (ESFT)

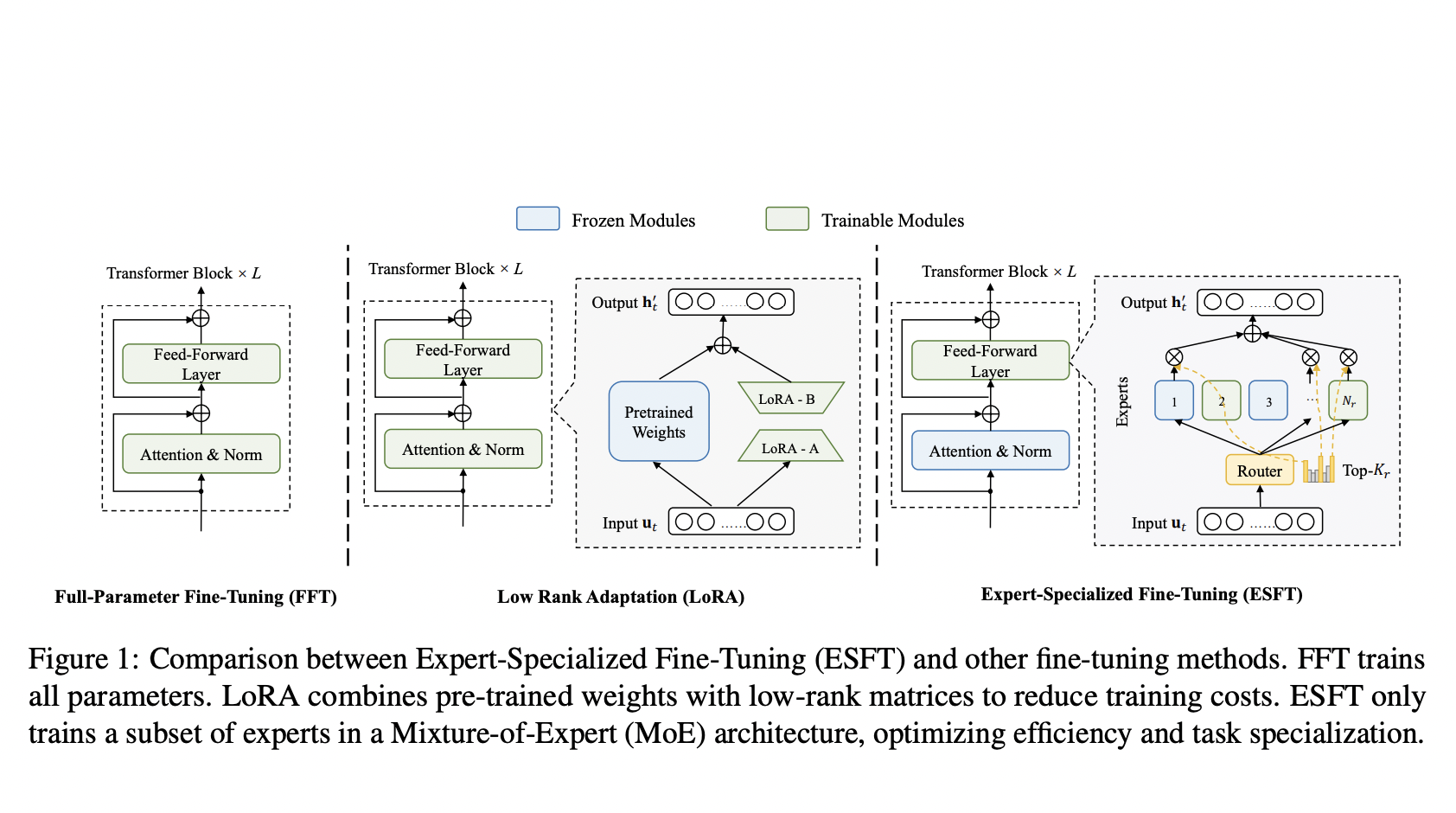

Продвижение в области обработки естественного языка (NLP) позволяет оптимизировать большие языковые модели (LLM) для конкретных задач. Однако, традиционные методы тонкой настройки моделей могут быть ресурсоемкими и приводить к переобучению. Для решения этой проблемы исследователи DeepSeek AI и Университета Нортвестерн разработали метод ESFT, который позволяет снизить потребление памяти до 90% и время обучения до 30%.

Преимущества ESFT:

- Выбор подмножества экспертов с высокой релевантностью для задачи

- Значительное сокращение вычислительных затрат

- Поддержание специализации экспертов для оптимальной производительности

- Превосходные результаты на различных задачах

ESFT демонстрирует эффективность в снижении затрат на обучение и хранение без ущерба для общей производительности модели. Этот метод обещает стать мощным инструментом для настройки больших языковых моделей в будущем.