Оптимизация эффективности Feedforward Neural Networks (FFNs) в архитектурах трансформеров

Оптимизация эффективности Feedforward Neural Networks (FFNs) в архитектурах трансформеров представляет собой значительное вызов в области искусственного интеллекта (ИИ). Большие языковые модели (LLMs) требуют значительных вычислительных ресурсов, что ограничивает их применимость и вносит экологические проблемы. Эффективное решение этой проблемы является ключевым для продвижения устойчивых практик в области ИИ и повышения доступности передовых технологий ИИ за счет снижения операционных затрат.

Практические решения

Для повышения эффективности FFN часто используются методы, такие как аппроксимации низкого ранга и структурированные матрицы. Однако существующие методы часто сталкиваются с ограничениями в реальных сценариях, такими как плохая динамика оптимизации и недостаточная эффективность в онлайн-декодировании.

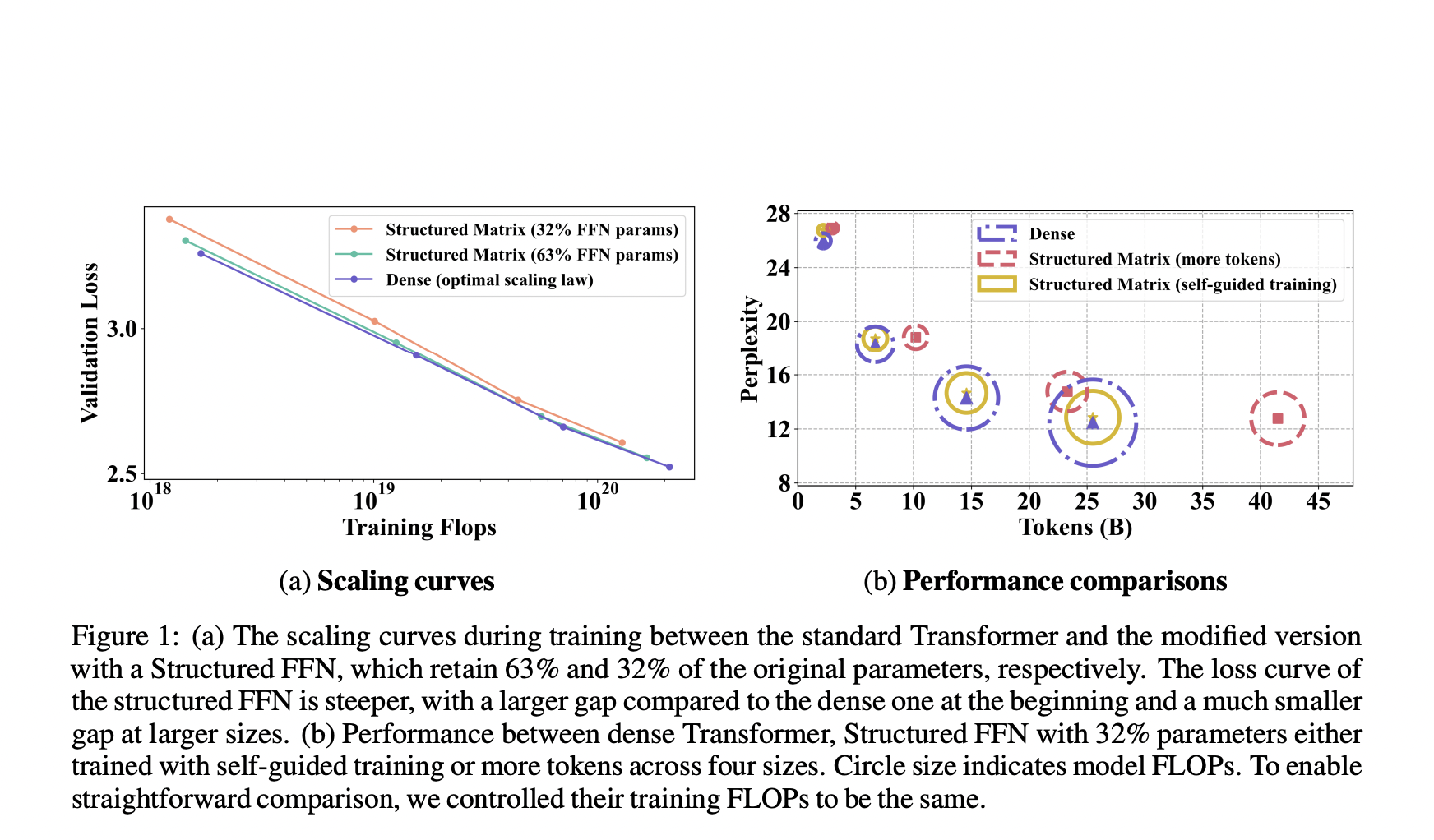

Команда исследователей из Google DeepMind и EPFL предлагает гибридную структуру, объединяющую низкоранговые и блочно-диагональные матрицы с методом, называемым «самонаправляемое обучение». Этот новый метод направлен на решение проблем оптимизации путем введения плотной матрицы в начальной фазе обучения, которая постепенно уступает место структурированным матрицам. Этот подход обеспечивает более стабильное обучение и быструю сходимость.

Структурированные модели FFN значительно повышают эффективность обучения и вывода. Предложенные модели показали ускорение обучения в 1,35 раза и увеличение скорости вывода FFN в 2,5 раза при незначительном увеличении перплексии. Метод «самонаправляемого обучения» привел к снижению перплексии на 0,4 в модели с 1,3 миллиарда параметров при постоянных FLOPs обучения.

В заключение, данное исследование представляет собой значительный вклад в оптимизацию больших языковых моделей путем внедрения гибридного структурированного подхода FFN в сочетании с самонаправляемым обучением. Это инновационное решение решает критические ограничения существующих методов, приводя к улучшению эффективности обучения и производительности модели.