«`html

Токенизация в LLM: обнаружение и устранение проблемных токенов

Токенизация является ключевым элементом в вычислительной лингвистике, особенно в обучении и функционировании больших языковых моделей (LLM). Этот процесс включает в себя разделение текста на управляемые части или токены, что является основой для обучения и работы модели. Эффективная токенизация может значительно улучшить производительность модели, но могут возникать проблемы, когда токены в словаре модели недостаточно представлены или отсутствуют в обучающих наборах данных, что приводит к появлению «пристрельных токенов». При обработке новых входных данных эти токены могут нарушить работу модели и привести к непредсказуемым результатам.

Проблема токенизатора и модели

Частой проблемой в LLM является несоответствие между обучением токенизатора и обучением модели. Часто токенизаторы обучаются отдельно с использованием различных наборов данных, что может существенно отличаться от данных, используемых для обучения модели. Это различие может привести к недостаточному обучению некоторых токенов словаря. Известный токен «_SolidGoldMagikarp» является примером пристрельного токена, который может вызывать нежелательное поведение модели, такое как галлюцинации или выдача бессмысленных результатов.

Новый подход к обнаружению пристрельных токенов

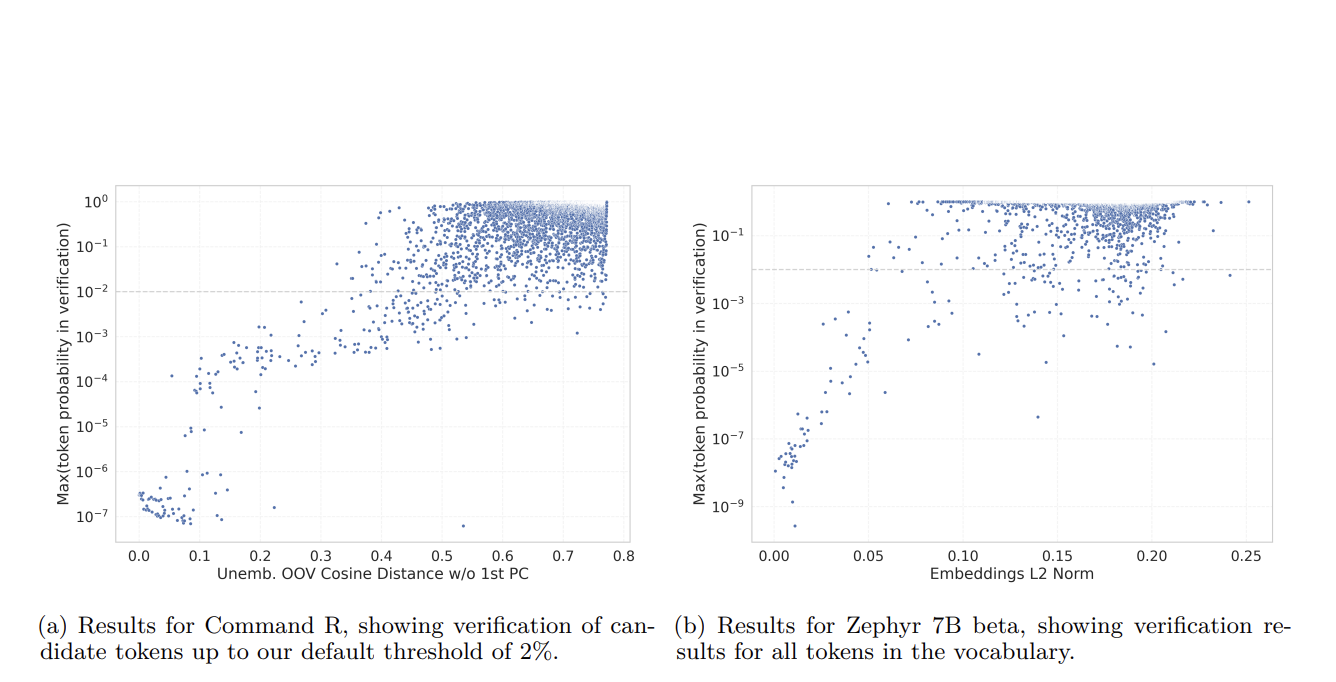

Исследователи из Cohere представляют новый подход, который использует веса вложения модели для автоматизации и масштабирования обнаружения недостаточно обученных токенов. Они разработали метод анализа этих весов для выявления аномалий, свидетельствующих о недостаточном обучении. Путем оценки матрицы вложения модели исследование выявляет токены, веса вложения которых значительно отличаются от весов хорошо представленных токенов. Этот метод обеспечивает систематический подход к выявлению пристрельных токенов путем расчета вариации и распределения весов вложения и их сравнения с нормативной моделью должным образом обученных токенов.

Эффективность нового метода

Исследование продемонстрировало эффективность нового метода, применяя его к нескольким известным моделям, включая варианты Google BERT и OpenAI GPT. Анализ выявил значительный процент словаря токенизатора, до 10% в некоторых случаях, как недостаточно обученных. Эти токены часто являются специализированными или редко используемыми словами, которые проявляют наибольшие расхождения в образцах весов вложения.

Значимость исследования

Это исследование имеет значительные последствия для разработки и поддержания LLM. Путем использования автоматических методов для обнаружения и устранения недостаточно обученных токенов разработчики могут улучшить точность и надежность языковых моделей. Это важно, поскольку LLM все чаще используются в различных приложениях, от автоматизированных помощников в написании до сложных разговорных агентов.

Заключение

Это исследование выявляет критическую уязвимость в обучении LLM и представляет масштабируемое решение для устранения этой проблемы. Внедрение автоматических методов обнаружения недостаточно обученных токенов позволяет проводить более надежные процессы обучения, обеспечивая подготовку всех токенов словаря модели к реальным приложениям. Это исследование повышает эффективность и надежность языковых моделей, открывая путь к более надежным и эффективным инструментам обработки естественного языка.

«`