«`html

Раскрытие потенциала больших языковых моделей: улучшение генерации обратной связи в образовании в области вычислительной техники

Обратная связь является ключевым элементом успеха студентов, особенно в условиях растущего спроса на курсы по вычислительной технике. Автоматизированные инструменты, включающие методы анализа и тестовые фреймворки, становятся все более популярными, но часто требуют более полезных рекомендаций. Недавние достижения в области больших языковых моделей (LLM) показывают потенциал в предоставлении быстрой обратной связи, сходной с человеческой. Однако сохраняются опасения относительно точности, надежности и этических последствий использования собственных LLM, что требует изучения альтернатив с открытым исходным кодом в образовании в области вычислительной техники.

Практические решения и ценность

Автоматизированная генерация обратной связи в образовании в области вычислительной техники долгое время оставалась сложной задачей, сосредоточенной в основном на выявлении ошибок, а не на предоставлении конструктивных рекомендаций. LLM представляют собой многообещающее решение этой проблемы. Недавние исследования исследовали использование LLM для автоматизированной генерации обратной связи, но выявили ограничения в их производительности. Хотя некоторые исследования показывают, что LLM, такие как GPT-3 и GPT-3.5, могут выявлять проблемы в коде студентов, они также проявляют несогласованность и неточности в обратной связи. Кроме того, современные модели новейшего поколения испытывают трудности в сравнении с человеческой производительностью при предоставлении обратной связи по упражнениям по программированию. Концепция использования LLM в качестве судей для оценки выводов других LLM, называемая LLM-как-судьи, получила распространение. Этот подход показал многообещающие результаты, приводя к тому, что модели, такие как GPT-4, достигают высоких уровней согласия с человеческими суждениями.

Исследователи из Университета Аалто, Университета Йювяскюля и Университета Окленда предоставляют тщательное исследование для оценки эффективности LLM в предоставлении обратной связи по программам, написанным студентами, и для изучения того, могут ли LLM с открытым исходным кодом конкурировать с собственными в этом отношении. Основное внимание уделяется обратной связи, выявляющей ошибки в коде студентов, такие как ошибки компилятора или сбои тестов. Вначале оценки сравнивают программную обратную связь от GPT-4 с экспертными оценками людей, устанавливая базовую линию для оценки качества обратной связи, созданной LLM. Затем исследование оценивает качество обратной связи от различных LLM с открытым исходным кодом по сравнению с собственными моделями. Для решения этих исследовательских вопросов используются существующие наборы данных и новая обратная связь, созданная моделями с открытым исходным кодом, оцениваемая с использованием GPT-4 в качестве судьи.

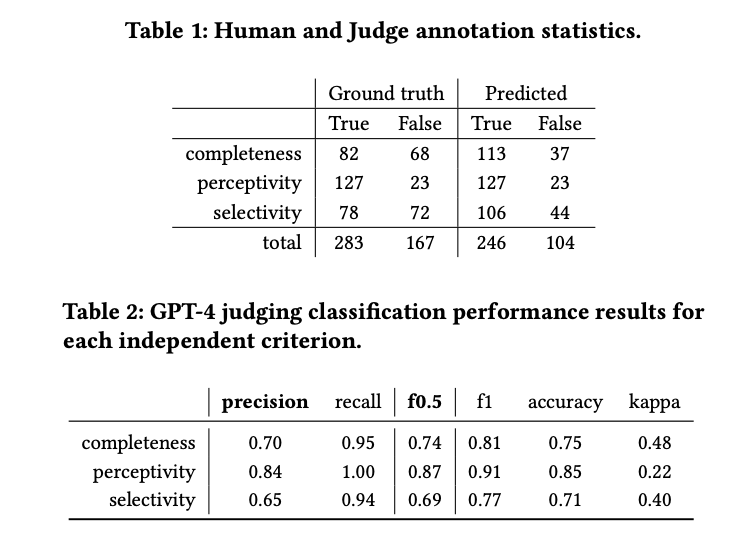

Были использованы данные из вводного курса по программированию Университета Аалто, включающие запросы на помощь студентов и обратную связь, созданную GPT-3.5. Критерии оценки сосредоточены на полноте, восприимчивости и селективности обратной связи. Обратная связь оценивалась как качественно, так и автоматически с использованием GPT-4. Модели с открытым исходным кодом оценивались наряду с собственными, используя систему оценки на основе рубрик. GPT-4 оценивал качество обратной связи, созданной LLM, на основе аннотаций людей. Точность и F0.5-оценка были ключевыми метриками, используемыми для оценки производительности судьи.

Результаты показывают, что хотя большинство обратной связи воспринимается восприимчиво, лишь немногие являются полными, и многие содержат вводящий в заблуждение контент. GPT-4 склонен оценивать обратную связь более положительно по сравнению с человеческими аннотаторами, что указывает на некоторую положительную предвзятость. Результаты классификации производительности для GPT-4 показывают довольно хорошую производительность в классификации полноты и немного более низкую производительность в селективности. Оценки восприимчивости выше, частично из-за смещения данных. Коэффициент Каппа указывает на умеренное согласие, при этом GPT-4 сохраняет высокую полноту по всем критериям, обеспечивая при этом разумную точность и точность.

Подводя итог, данное исследование изучило эффективность GPT-4 в оценке автоматически созданной программной обратной связи и оценило производительность различных больших языковых моделей, включая модели с открытым исходным кодом, в создании обратной связи по коду студентов. Результаты показывают, что GPT-4 обещает надежно оценивать качество автоматически созданной обратной связи. Кроме того, модели языков с открытым исходным кодом демонстрируют потенциал в создании программной обратной связи. Это указывает на то, что обратная связь, созданная LLM, может служить экономически эффективным и доступным ресурсом в учебной среде, позволяя преподавателям и помощникам преподавателей сосредотачиваться на более сложных случаях, в которых LLM в настоящее время могут не справляться с помощью студентов.

«`