Применение трансформерных нейронных сетей в различных задачах

Трансформерные нейронные сети демонстрируют отличные результаты в обработке текста, редактировании и вопросно-ответных системах. Увеличение количества параметров моделей обычно приводит к улучшению их производительности, измеряемой перплексией и высокой точностью выполнения задач. Однако большие модели иногда могут привести к плохим результатам. Например, модель MiniCPM с 2 миллиардами параметров проявляет сопоставимые возможности с более крупными моделями, такими как Llama2-7B, Mistral-7B, Gemma-7B и Llama-13B. Кроме того, объем высококачественных данных может не успевать за увеличением вычислительных ресурсов для обучения более крупных моделей.

Текущие методы преодоления ограничений

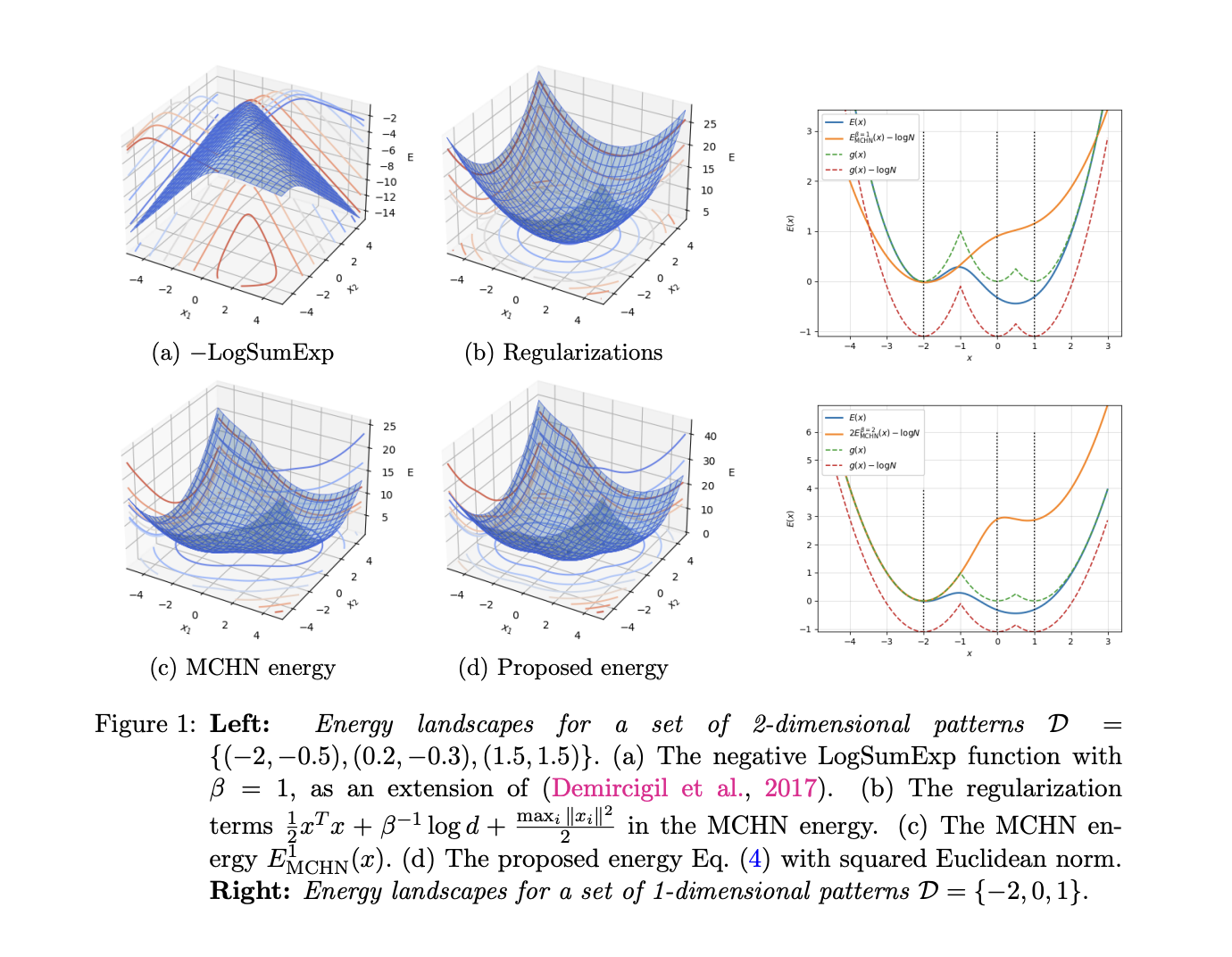

Существующие методы преодоления таких недостатков включают масштабные законы, энергетические модели и модели Хопфилда. В масштабных законах производительность моделей увеличивается при увеличении их размера и объема обучающих данных. Энергетические модели стали известны как фундаментальный инструмент моделирования в различных областях машинного обучения. Основная идея этого метода заключается в моделировании нейронной сети с использованием параметризованной плотности вероятности для представления распределения в виде обучаемой энергетической функции. Наконец, модель Хопфилда, в которой классические сети Хопфилда были разработаны как пример ассоциативной памяти.

Исследования и практические решения

Исследователи из Центрального исследовательского института, 2012 Лабораторий Huawei Technologies Co., Ltd. представили теоретическую основу, сфокусированную на процессе запоминания и динамике производительности трансформерных языковых моделей (LMs). Они провели серию экспериментов с использованием GPT-2 на различных объемах данных для преодоления признаков насыщения, а также обучили ванильные трансформерные модели на наборе данных, состоящем из 2 миллионов токенов. Результаты этих экспериментов подтвердили теоретические выводы и предложили важные теоретические идеи об оптимальной перекрестной энтропии, которая может направлять и улучшать принятие решений при обучении модели.

Практическое применение

Для практического применения было обучено 12-слойное трансформерное LM с использованием токенизатора и архитектуры GPT-2 small на наборе данных OpenWebText. Этот набор данных похож на набор данных WebText, используемый для обучения исходной модели GPT-2, и содержит 9 миллиардов токенов из 8 013 769 документов. Для обучения трех моделей использовали различные объемы данных: подмножество, содержащее первые 1% (90 миллионов) и 0.1% (9 миллионов) данных OpenWebText. Кроме того, обучались ванильные трансформерные модели на небольшом объеме высококачественных данных, содержащих пары английских предложений в декларативной форме с размером словаря 68 слов, где задача состояла в преобразовании декларативных предложений в вопросы.

Заключение и практические рекомендации

В заключение, исследователи представили теоретическую основу, сфокусированную на процессе запоминания и динамике производительности трансформерных языковых моделей. В данной статье сети, основанные на трансформерах, моделируются с использованием ассоциативной памяти, а также выделяется перекрестная энтропия для размеров модели и данных. Кроме того, проводятся эксперименты с использованием GPT-2 различных объемов данных и обучения ванильных трансформерных моделей на наборе данных из 2 миллионов токенов. Наконец, для слоистой структуры моделей трансформеров создается глобальная энергетическая функция с использованием метода мажоризации-минимизации.