Расширение возможностей SirLLM: улучшение запоминания и механизмов внимания

Быстрый рост больших языковых моделей (LLM) способствует развитию многочисленных приложений обработки естественного языка (NLP), таких как чат-боты, помощники в написании текстов и помощники в программировании. Однако эти приложения часто требуют неограниченной длины ввода и надежных памятных возможностей, которых в настоящее время не хватает у существующих LLM. Увеличение длины предварительного обучения текста является непрактичным, что требует исследований в области обеспечения LLM способностью обрабатывать бесконечные длины ввода, сохраняя при этом память.

Практические решения и ценность

Недавние исследования сосредотачиваются на улучшении длины контекста ввода LLM, в основном путем оптимизации механизмов внимания. Техники, такие как скользящее окно внимания и StreamLLM, направлены на расширение длины ввода, но сталкиваются с проблемами погружения внимания и потери памяти, что приводит к исследованиям фильтрации менее важных токенов для поддержания более длительных памятных интервалов.

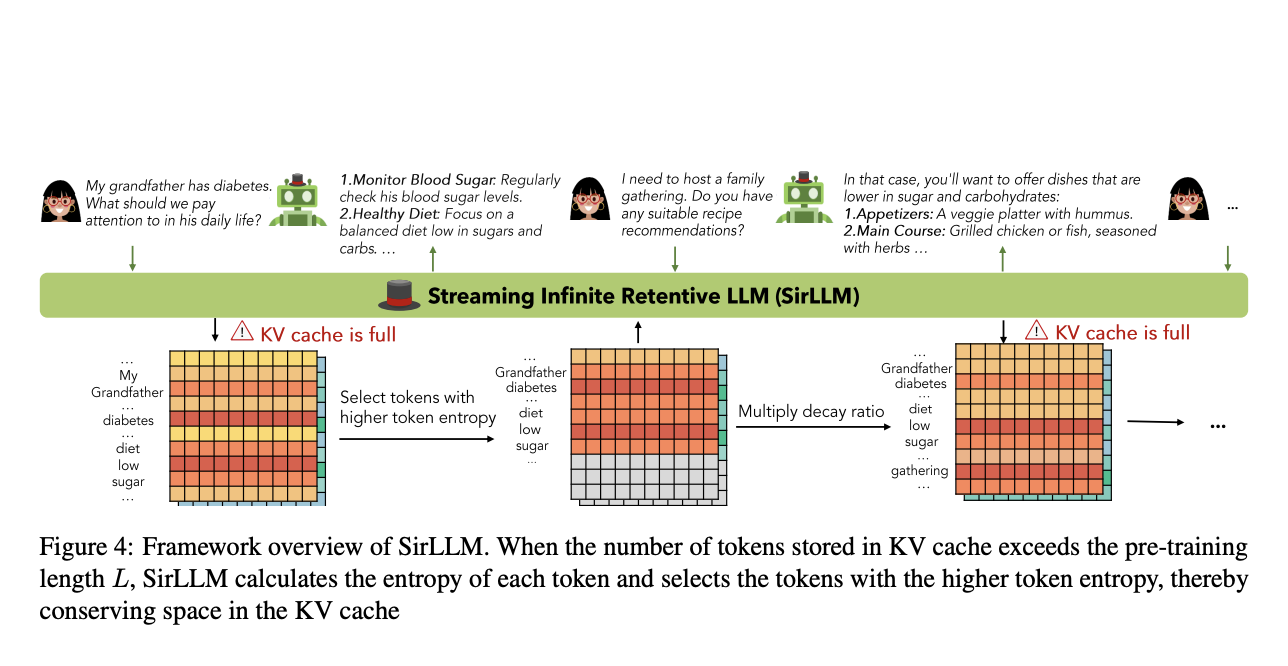

Исследователи из Университета Шанхайского Цзяотун и Университета Уханя представляют модель Streaming Infinite Retentive LLM (SirLLM), позволяющую LLM сохранять расширенную память в диалогах бесконечной длины без необходимости тонкой настройки модели. SirLLM использует метрику Token Entropy и механизм затухания памяти для фильтрации ключевых фраз, улучшая долгосрочную и адаптивную память LLM.

Анализ набора данных Rock-Paper-Scissors демонстрирует последовательное превосходство SirLLM по сравнению с базовым StreamLLM в играх с разнообразными предпочтениями игроков. SirLLM проявляет стабильное улучшение показателей победы над игроками с различными предпочтениями, поддерживая этот повышенный уровень производительности во всех оцениваемых моделях.

Внедрение SirLLM решает критические проблемы управления бесконечными длинами ввода и памятью. SirLLM достигает сохранения диалогов без необходимости тонкой настройки модели, укрепляя фокус на ключевую информацию. На трех специально разработанных задачах: DailyDialog, Grocery Shopping и Rock-Paper-Scissors, SirLLM последовательно демонстрирует стабильное улучшение по сравнению с существующими моделями, независимо от сложности или длины диалога.