«`html

Улучшение производительности LLM с помощью подхода BoT

Различные крупные языковые модели (LLM), такие как GPT-4, PaLM и LLaMA, продемонстрировали выдающуюся производительность в различных задачах рассуждения. Для дальнейшего улучшения функциональности и производительности LLM существуют более эффективные методы подсказок и увеличения размера модели, оба из которых повышают производительность рассуждения.

Применение подхода BoT для улучшения производительности LLM

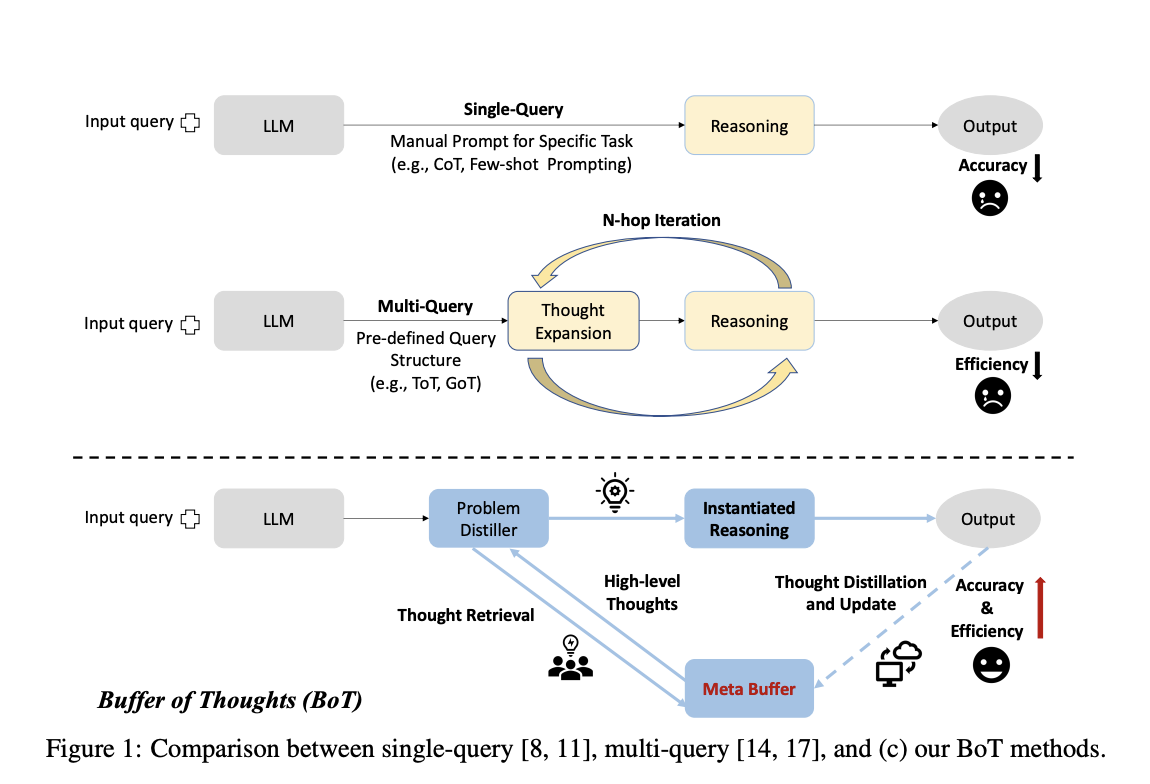

BoT — инновационная и гибкая система для улучшения точности, эффективности и устойчивости рассуждения LLM в широком спектре задач. Ключевым компонентом BoT является мета-буфер, маленькая библиотека, которая хранит набор обобщенных, высокоуровневых идей (шаблоны мыслей), извлеченных из различных процедур решения проблем. Эти шаблоны мыслей могут быть многократно использованы для других задач, облегчая эффективное рассуждение и конфигурацию с конкретной структурой рассуждения.

BoT разработан для стабильности и масштабируемости, поэтому включает менеджер буфера для динамического обновления мета-буфера. Таким образом, емкость мета-буфера эффективно увеличивается по мере выполнения задач. Три основных преимущества этого подхода:

- Повышенная точность: Используя общие шаблоны мыслей, можно адаптивно применять высокоуровневые мысли для решения различных задач, что устраняет необходимость создавать структуры рассуждения с нуля и драматически повышает точность рассуждения.

- Оптимизация рассуждения: Применение информативных исторических структур рассуждения может упростить процессы рассуждения и устранить громоздкие многократные запросы.

- Улучшение устойчивости: Подход BoT к извлечению и применению мыслей отражает процессы человеческого мозга, повышая способность LLM последовательно решать аналогичные проблемы.

Практические преимущества BoT

Экспериментальные результаты показывают, что BoT значительно повышает точность, эффективность и устойчивость LLM в различных задачах. Эти практические преимущества делают BoT многообещающим инструментом для улучшения производительности LLM в реальных приложениях.

Команда исследователей провела обширные эксперименты на десяти сложных задачах, требующих много рассуждения. Средние затраты BoT составляют всего 12% от многократных запросов, превосходя предыдущие методы SOTA на 51% в задаче «Шах и мат за один ход», на 11% в игре «24» и на 20% в геометрических фигурах.

Предложенный подход значительно повышает точность, сохраняя при этом эффективность и устойчивость рассуждения. Однако в случае проблем, требующих человекоподобного изобретательства, метод имеет ограничения, так как для таких задач часто отсутствует точный шаблон мысли. Кроме того, полученные шаблоны мыслей могут быть низкого качества, если BoT использует менее устойчивую модель для инициализации мета-буфера.

В целом, BoT показывает следующие перспективы: 1. Создание системы открытого домена, такой как модель агента, путем объединения BoT с внешними ресурсами. 2. Оптимизация дистилляции шаблонов мыслей, что может значительно улучшить их способность как шаблонов для все более сложных задач.

Больше информации о работе можно найти в статье и на GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта.

«`