«`html

Объявление о выпуске Open LLM Leaderboard v2 от Hugging Face: новые возможности и практические решения

Недавно Hugging Face объявила о выпуске Open LLM Leaderboard v2, существенного обновления, направленного на решение проблем и ограничений предыдущей версии. Новый Leaderboard вводит более строгие бенчмарки, улучшенные методы оценки и более справедливую систему оценки, обещая оживить конкурентную среду для языковых моделей.

Решение проблемы насыщения бенчмарков

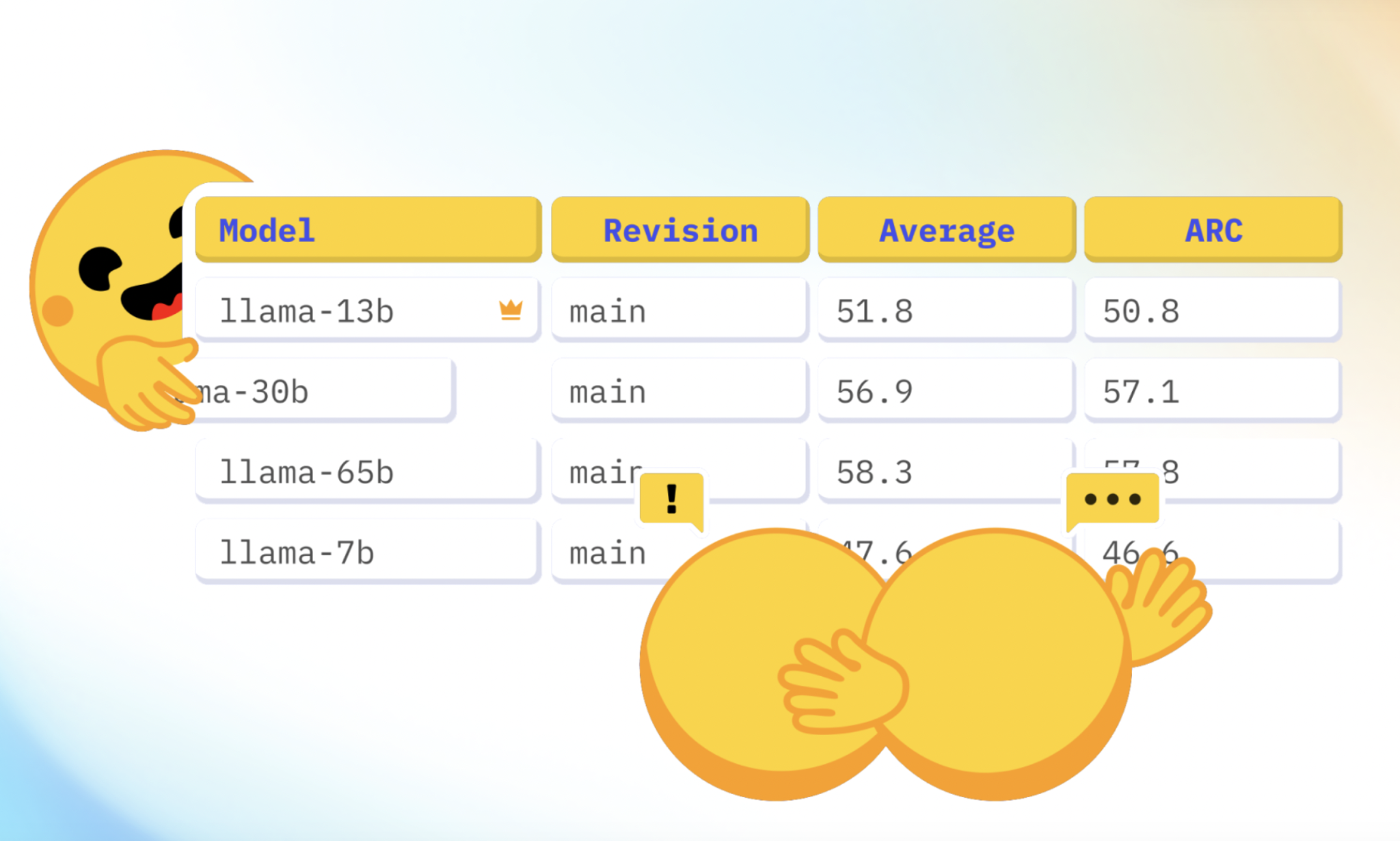

Оригинальный Open LLM Leaderboard стал ключевым ресурсом в сообществе машинного обучения, привлекая более 2 миллионов уникальных посетителей и 300 000 активных пользователей ежемесячно. Однако, увеличение производительности моделей привело к насыщению бенчмарков. Модели начали достигать базовой человеческой производительности на бенчмарках, таких как HellaSwag, MMLU и ARC, что снизило их эффективность. Кроме того, некоторые модели проявили признаки контаминации, так как были обучены на данных, аналогичных бенчмаркам, что подорвало целостность их оценок.

Введение новых бенчмарков

Для решения этих проблем Open LLM Leaderboard v2 представляет шесть новых бенчмарков, охватывающих различные возможности моделей:

- MMLU-Pro: улучшенная версия набора данных MMLU с десятью вариантами ответов вместо четырех, требующая более глубокого мышления и экспертного обзора для уменьшения шума.

- GPQA (Google-Proof Q&A Benchmark): высоко сложный набор знаний, разработанный экспертами в области, с механизмами защиты от контаминации.

- MuSR (Multistep Soft Reasoning): набор алгоритмически созданных сложных задач, включая детективные и оптимизационные задачи, для проверки умения рассуждать и анализировать контекст на большом протяжении.

- MATH (Mathematics Aptitude Test of Heuristics, Level 5 subset): задачи соревнований уровня старшей школы, сосредоточенные на самых сложных вопросах.

- IFEval (Instruction Following Evaluation): проверка способности моделей следовать явным инструкциям с использованием строгих метрик.

- BBH (Big Bench Hard): подмножество из 23 сложных задач из набора данных BigBench, охватывающих многошаговую арифметику, алгоритмическое рассуждение и понимание языка.

Более справедливые рейтинги с нормализованными оценками

Значительное изменение в новом Leaderboard — использование нормализованных оценок для ранжирования моделей. Ранее сырые оценки суммировались, что могло искажать производительность из-за различной сложности бенчмарков. Теперь оценки нормализуются между случайной базовой линией (0 баллов) и максимально возможным баллом (100 баллов). Этот подход обеспечивает более справедливое сравнение различных бенчмарков, предотвращая перекос влияния отдельного бенчмарка на окончательное ранжирование.

Например, в бенчмарке с двумя вариантами ответов на вопрос, случайная базовая линия получила бы 50 баллов. Эта сырая оценка будет нормализована до 0, выравнивая оценки между бенчмарками и предоставляя более четкую картину производительности модели.

Улучшенная воспроизводимость и интерфейс

Hugging Face обновила набор оценок в сотрудничестве с EleutherAI для улучшения воспроизводимости. Обновления включают поддержку дельта-весов (тонкая настройка/адаптация LoRA), новую систему регистрации, совместимую с Leaderboard, и использование чат-шаблонов для оценки. Кроме того, были проведены ручные проверки всех реализаций для обеспечения согласованности и точности. Интерфейс также значительно улучшен. Благодаря команде Gradio, в частности, Фредди Болтону, новый компонент Leaderboard загружает данные на стороне клиента, делая поиск и выбор столбцов мгновенными. Это улучшение предоставляет пользователям более быстрый и безупречный опыт.

Приоритет моделей, важных для сообщества

Новый Leaderboard вводит категорию «выбор хранителя», выделяя высококачественные модели из различных источников, включая крупные компании, стартапы, коллективы и отдельных участников. Этот подборный список направлен на включение передовых LLM и приоритизацию оценок наиболее полезных моделей для сообщества.

Голосование за актуальность модели

Была внедрена система голосования для управления большим объемом представленных моделей. Члены сообщества могут голосовать за предпочтительные модели, и те, которые получат больше голосов, будут приоритизированы для оценки. Эта система обеспечивает оценку наиболее ожидаемых моделей в первую очередь, отражая интересы сообщества.

В заключение, Open LLM Leaderboard v2 от Hugging Face представляет собой значительный вех в оценке языковых моделей. Благодаря более сложным бенчмаркам, более справедливой системе оценки и улучшенной воспроизводимости, он направлен на расширение границ развития моделей и предоставление более надежных исследований возможностей модели. Команда Hugging Face оптимистично смотрит в будущее, ожидая продолжения инноваций и улучшений с оценкой большего количества моделей на этом новом, более строгом Leaderboard.

«`