Увеличение надежности LLM: Подход Lookback Lens к обнаружению галлюцинаций

Большие языковые модели (LLM) типа GPT-4 обладают впечатляющими возможностями в задачах генерации текста, таких как суммирование и ответы на вопросы. Однако часто они производят «галлюцинации», генерируя контент, который фактически неверен или контекстуально несоответствующий. Проблема особенно остра, когда LLM получают правильные факты, но по-прежнему генерируют неточные выводы, называемые «контекстуальными галлюцинациями». Эти ошибки подрывают надежность LLM в приложениях, где точность критична, таких как ответы на вопросы на основе документов и суммирование.

Практические решения и ценность

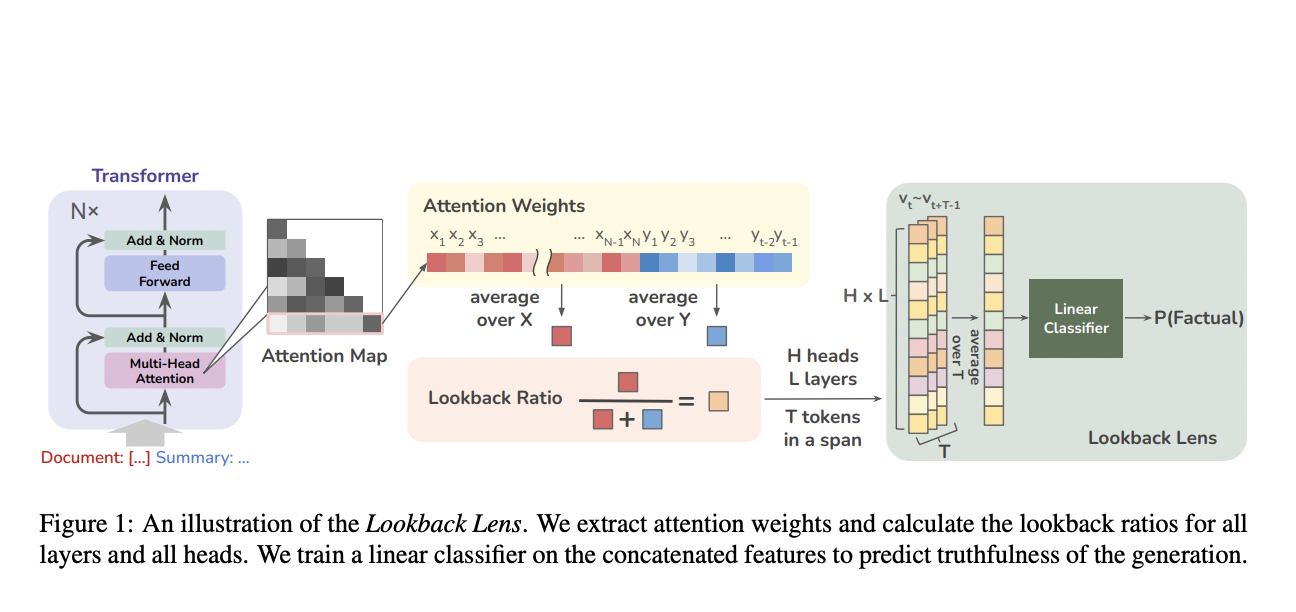

Для решения этой проблемы исследователи из Массачусетского технологического института и Университета Вашингтона предлагают новый подход, использующий карты внимания LLM. Подход Lookback Lens представляет собой уникальное и инновационное решение, основанное на понимании того, что контекстуальные галлюцинации связаны с тем, насколько LLM обращают внимание на предоставленный контекст по сравнению с собственно сгенерированными токенами.

Lookback Lens работает путем вычисления коэффициента возврата взгляда на каждом шаге генерации. Этот коэффициент рассчитывается для каждой головы в каждом слое модели трансформера с несколькими слоями и головами. Коэффициент возврата взгляда — это вес внимания, сосредоточенный на контекстных токенах, деленный на общий вес внимания как на контекст, так и на новые токены. Эти коэффициенты объединяются в вектор признаков, который затем используется для обучения линейного классификатора для обнаружения галлюцинаций.

Эффективность Lookback Lens подтверждается экспериментами по задачам суммирования и ответов на вопросы. Результаты показывают, что Lookback Lens работает сравнимо или даже лучше, чем более сложные детекторы, использующие весь скрытый статус LLM. Важно отметить, что Lookback Lens может быть передан на другие модели и задачи без повторного обучения, что подчеркивает его надежность и универсальность.

Исследователи предлагают стратегию декодирования с управляемым классификатором для дальнейшего смягчения галлюцинаций в процессе генерации текста. Этот подход включает Lookback Lens в процесс декодирования, оценивая несколько токенов на каждом шаге и выбирая тот, который предсказан как наименее вызывающий галлюцинации. Эта стратегия уменьшает галлюцинации на 9,6% в задаче суммирования XSum, подчеркивая потенциал Lookback Lens в практических приложениях.

Проблема контекстуальных галлюцинаций в LLM является значительной и влияет на надежность этих моделей в критических приложениях. Lookback Lens представляет собой простое, но эффективное решение, использующее карты внимания для обнаружения и смягчения галлюцинаций. Его способность передаваться на другие модели и задачи без повторного обучения дополнительно подчеркивает его полезность. Этот подход является многообещающим шагом к более точному и надежному контенту, созданному LLM.