«`html

LoRA-Pro: Революционный подход к машинному обучению, сокращающий разрыв в производительности между методами низкоранговой адаптации и полным донастройкой

Методы параметрически эффективной донастройки (PEFT) стали неотъемлемой частью машинного обучения. Они позволяют крупным моделям адаптироваться к новым задачам без больших вычислительных ресурсов. Путем донастройки только небольшого подмножества параметров, сохраняя большую часть модели замороженной, методы PEFT направлены на то, чтобы сделать процесс адаптации более эффективным и доступным. Этот подход критически важен для развертывания крупных фундаментальных моделей, ограниченных своими высокими вычислительными затратами и обширным количеством параметров.

Применение метода LoRA-Pro

Исследователи из Университета науки и технологий Китая и Института автоматизации Китайской академии наук и Университета Китайской академии наук представили метод LoRA-Pro. Этот новаторский метод сокращает разрыв в производительности между методом LoRA и полной донастройкой. LoRA-Pro улучшает оптимизационный процесс LoRA, вводя концепцию «Эквивалентного градиента». Этот подход позволяет исследователям измерить различия в оптимизационном процессе между LoRA и полной донастройкой, а затем минимизировать эти различия для улучшения производительности. Таким образом, LoRA-Pro гарантирует, что процесс донастройки тесно имитирует полную донастройку.

Экспериментальная проверка эффективности

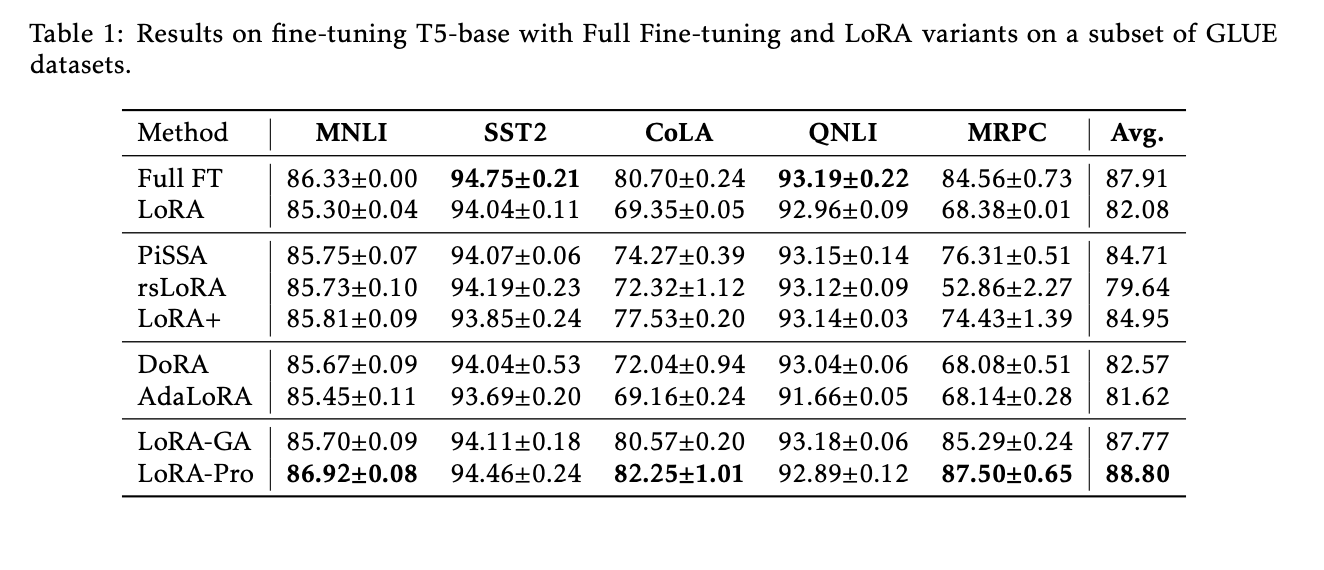

Эффективность LoRA-Pro была подтверждена через обширные эксперименты на задачах обработки естественного языка. Метод был протестирован на модели T5-base с использованием подмножества наборов данных GLUE. Результаты показали, что LoRA-Pro достиг наивысших показателей на трех из пяти наборов данных, превысив стандартный LoRA на 6,72%. В частности, LoRA-Pro показал 86,92% на MNLI, 94,46% на SST-2 и 87,50% на MRPC, демонстрируя свою превосходную производительность. Эти результаты подчеркивают способность LoRA-Pro сократить разрыв в производительности по сравнению с полной донастройкой, что делает его значительным улучшением существующих методов PEFT.

Заключение

Введение LoRA-Pro является существенным прорывом в параметрически эффективной донастройке. Решая недостатки оптимизации LoRA и вводя концепцию Эквивалентного градиента, исследователи разработали метод, который сокращает разрыв в производительности между LoRA и полной донастройкой. Обширная экспериментальная проверка подтверждает, что LoRA-Pro сохраняет эффективность LoRA и достигает уровня производительности, близкого к полной донастройке. Это делает LoRA-Pro ценным инструментом для развертывания крупных фундаментальных моделей более ресурсоэффективным способом.

«`