Роль объяснимого искусственного интеллекта в ин витро-диагностике в соответствии с европейскими регуляциями

Искусственный интеллект становится все более важным в здравоохранении, особенно в ин витро-диагностике (IVD). Европейский регламент об ин витро-диагностике признает программное обеспечение, включая алгоритмы искусственного интеллекта и машинного обучения, как часть IVD. Этот регуляторный каркас представляет существенные вызовы для AI-основанных IVD, особенно тех, которые используют техники глубокого обучения. Эти системы искусственного интеллекта должны давать точные результаты и обеспечивать объяснимость для соблюдения регуляторных требований. Надежный искусственный интеллект необходим, поскольку он должен давать здравоохранительным специалистам уверенность в использовании ИИ в принятии решений, что требует разработки методов объяснимого искусственного интеллекта (xAI). Инструменты, такие как пропагация значимости слоев, могут помочь визуализировать элементы нейронной сети, которые вносят вклад в конкретные результаты, обеспечивая необходимую прозрачность.

Объяснимость и научная обоснованность в искусственном интеллекте для ин витро-диагностики

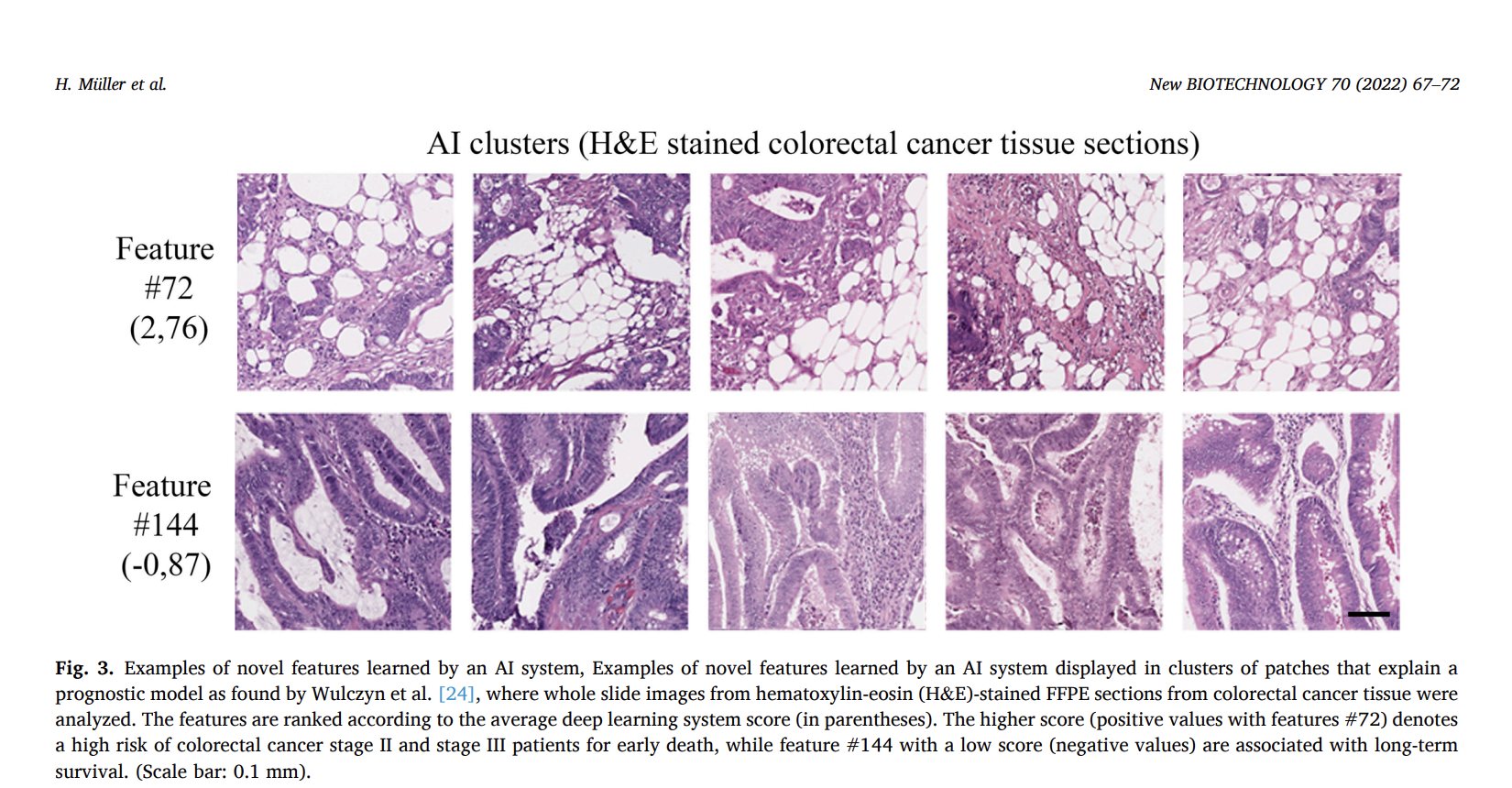

Регламент об ин витро-диагностике описывает научную обоснованность как связь между аналитом и конкретным клиническим состоянием или физиологическим состоянием. При применении этого к алгоритмам искусственного интеллекта результаты должны быть объяснимы, а не просто получены от непрозрачной модели «черного ящика». Это важно для подтвержденных диагностических методов и алгоритмов искусственного интеллекта, поддерживающих или заменяющих эти методы. Например, ИИ-система, разработанная для обнаружения и количественной оценки PD-L1 положительных опухолевых клеток, должна предоставлять патологоанатомам четкий и понятный процесс. Аналогично, в прогнозировании выживаемости при раке толстой кишки, выявленные ИИ-признаки должны быть объяснимы и подтверждены научными доказательствами, требуя независимой проверки для обеспечения надежности и точности результатов.

Объяснимость в оценке аналитической производительности для искусственного интеллекта в ин витро-диагностике

При оценке аналитической производительности искусственного интеллекта в ин витро-диагностике важно обеспечить, чтобы алгоритмы искусственного интеллекта точно обрабатывали входные данные по всему предполагаемому спектру. Это включает в себя учет пациентской популяции, заболеваний и качества сканирования. Методы объяснимого искусственного интеллекта играют ключевую роль в определении допустимых диапазонов входных данных и выявлении того, когда и почему ИИ-решения могут потерпеть неудачу, особенно в случае проблем с качеством данных или артефактов. Надлежащее управление данными и полное понимание тренировочных данных необходимы для избежания предвзятости и обеспечения надежной производительности ИИ в реальных приложениях.

Объяснимость в оценке клинической производительности для искусственного интеллекта в ин витро-диагностике

Оценка клинической производительности искусственного интеллекта в ин витро-диагностике оценивает способность ИИ предоставлять результаты, соответствующие конкретным клиническим условиям. Методы объяснимого искусственного интеллекта играют ключевую роль в обеспечении эффективной поддержки ИИ принятия решений. Эти методы направлены на то, чтобы процесс принятия решений ИИ был прослеживаемым, интерпретируемым и понятным для медицинских экспертов. Оценка различает между компонентами, обеспечивающими научное подтверждение, и теми, которые разъясняют медицински значимые факторы. Эффективная объяснимость требует статических объяснений и интерактивных интерфейсов, ориентированных на человека, соответствующих потребностям экспертов, обеспечивая более глубокое понимание причин и прозрачность в ИИ-помогаемых диагнозах.

Заключение

Для того чтобы ИИ-решения в ин витро-диагностике выполняли свою предназначенную цель, они должны демонстрировать научную обоснованность, аналитическую производительность и, при необходимости, клиническую производительность. Обеспечение прослеживаемости и надежности требует, чтобы объяснения могли быть воспроизводимо проверены различными экспертами, технически интероперабельны и понятны. Методы объяснимого искусственного интеллекта решают критические вопросы: почему работает ИИ-решение, когда его можно применить и почему оно дает конкретные результаты. В биомедицинской сфере, где у искусственного интеллекта огромный потенциал, объяснимый искусственный интеллект крайне важен для соблюдения регуляторных требований и для предоставления здравоохранительным специалистам возможности принимать обоснованные решения. Документ подчеркивает важность объяснимости и удобства для обеспечения достоверности и производительности ИИ-основанных IVD.