«`html

DeepSeek-Prover-V1.5: прорыв в формальном доказательстве теорем

Большие языковые модели (LLM) достигли значительных успехов в математическом рассуждении и доказательстве теорем, однако они сталкиваются с серьезными вызовами при формальном доказательстве теорем с использованием систем типа Lean и Isabelle. Эти системы требуют строгих выводов, соответствующих строгим формальным спецификациям, что представляет трудности даже для продвинутых моделей, таких как GPT-4.

Исследователи из DeepSeek-AI представили DeepSeek-Prover-V1.5, объединяющий сильные стороны генерации шагов доказательства и создания полного доказательства через механизм обрезки и возобновления. Этот метод начинается с генерации полного доказательства, где языковая модель создает полный код доказательства на основе утверждения теоремы. Затем производится проверка этого кода с помощью Lean Prover. Если обнаружена ошибка, код обрезается до первого сообщения об ошибке, и успешно сгенерированный фрагмент служит подсказкой для следующего сегмента доказательства. Последнее состояние от Lean 4 prover добавляется в качестве комментария к подсказке для повышения точности. Механизм обрезки и возобновления интегрирован в поиск по дереву Монте-Карло (MCTS), что позволяет гибкие точки обрезки, определяемые политикой поиска по дереву.

Преимущества DeepSeek-Prover-V1.5

- Усиление базовой модели дополнительным обучением на математических и кодовых данных, сосредоточенных на формальных языках, таких как Lean, Isabelle и Metamath.

- Улучшение набора данных автозавершения кода Lean 4 с помощью двух техник аугментации данных.

- Использование алгоритма GRPO для обучения с подкреплением от обратной связи от доказательств помощника (RLPAF).

- Применение улучшенного метода поиска по дереву Монте-Карло с использованием механизма обрезки и возобновления.

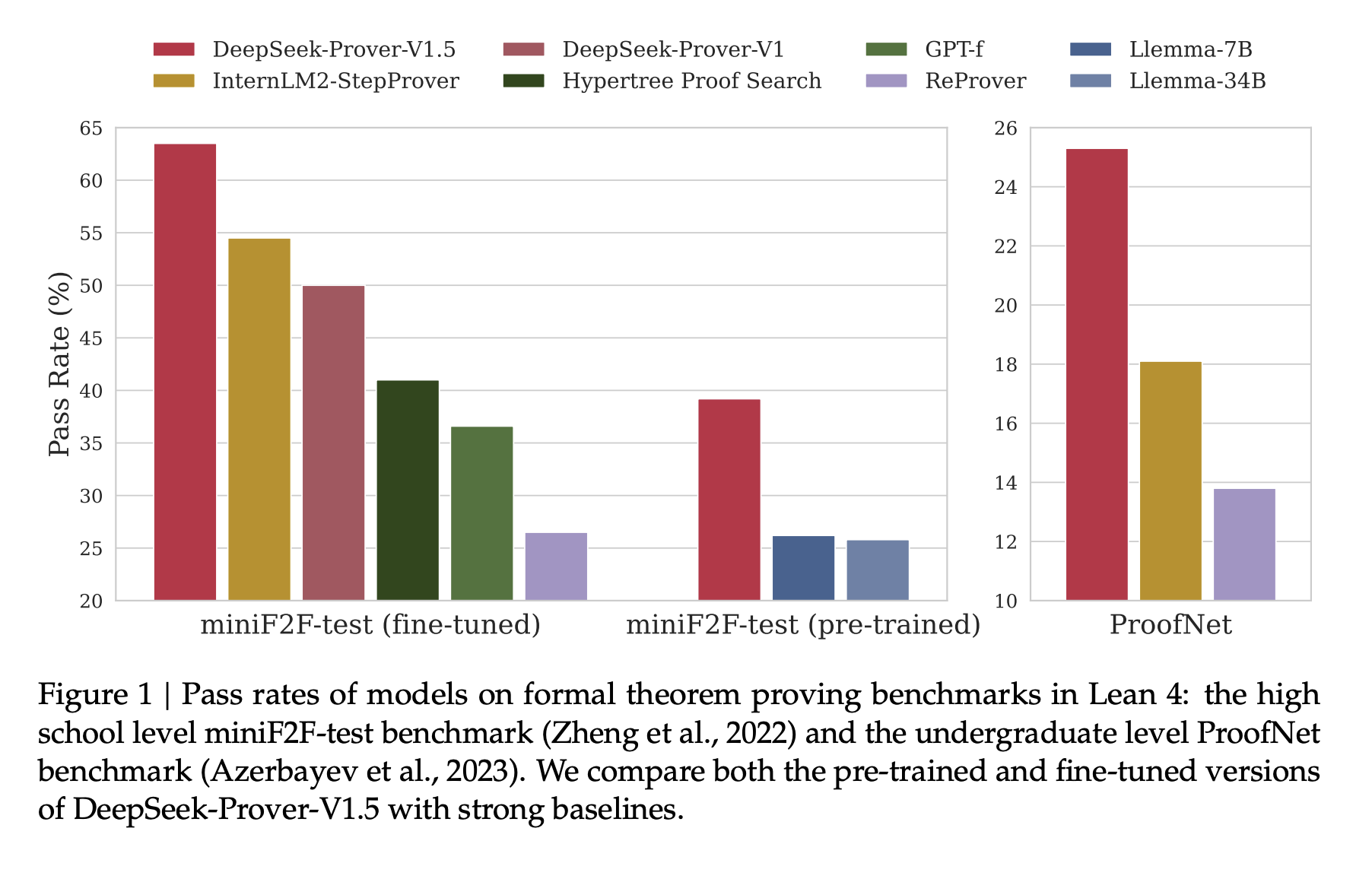

DeepSeek-Prover-V1.5 демонстрирует значительные достижения в формальном доказательстве теорем на различных платформах. На наборе данных miniF2F-test DeepSeek-Prover-V1.5-RL достиг 60,2% успешных прохождений при однопроходной генерации полного доказательства, что на 10,2 процентных пункта превышает предыдущий результат. Также он превзошел другие методы генерации полного доказательства и соответствовал ведущим методам поиска по дереву. Когда к нему добавили поиск по дереву RMaxTS, DeepSeek-Prover-V1.5-RL достиг уровня в 62,7% успешных прохождений. На наборе данных ProofNet DeepSeek-Prover-V1.5-RL достиг уровней успешных прохождений 22,6% и 25,3% в однопроходном и RMaxTS-улучшенном режиме соответственно, превзойдя существующие методы.

DeepSeek-Prover-V1.5, языковая модель с 7 миллиардами параметров, устанавливает новые стандарты в формальном доказательстве теорем с использованием Lean 4. Построенная на базе DeepSeek-Prover-V1.5-Base, она прошла специализированное предварительное обучение, комплексное обучение с учителем и обучение с подкреплением через GRPO. Модель включает в себя RMaxTS, инновационную вариацию метода поиска по дереву Монте-Карло, чтобы улучшить решение задач через обширное исследование. Эта рамка создает трубопровод подобный AlphaZero для формального доказательства теорем, используя итерацию эксперта и синтетические данные. Хотя в настоящее время фокус направлен на исследование, будущие разработки могут включать модель критика для оценки неполных доказательств, решая аспект эксплуатации обучения с подкреплением в доказательствах теорем.

Проверьте работу в Paper и GitHub. Вся заслуга за это исследование принадлежит его ученым. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram каналу и группе в LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему Reddit сообществу по машинному обучению с 48 тысячами подписчиков.

Найдите предстоящие вебинары по ИИ здесь.

«`