«`html

Магия декодирования: увеличение скорости LLaMA-моделей в приложениях с долгим контекстом

По мере того, как большие языковые модели (LLM) становятся все более распространенными в приложениях с долгим контекстом, таких как интерактивные чат-боты и анализ документов, обеспечение этих моделей низкой задержкой и высокой пропускной способностью становится значительной проблемой. Традиционное мнение подсказывает, что методы, такие как спекулятивное декодирование (SD), хотя и эффективны для снижения задержки, ограничены в увеличении пропускной способности, особенно для больших размеров пакетов. Однако новый прорывной подход под названием MagicDec оспаривает это предположение, демонстрируя, что SD может улучшить как задержку, так и пропускную способность для умеренных и длинных последовательностей, не жертвуя точностью.

Практические решения и ценность

Текущие методы обслуживания LLM часто требуют компромисса между задержкой и пропускной способностью. Техники, такие как vLLM и ORCA, могут достигать высокой пропускной способности, обслуживая больше запросов одновременно, но они не снижают задержку для отдельных запросов. С другой стороны, методы с потерями, такие как квантование и обрезка, могут улучшить оба показателя, но за счет снижения производительности модели. Спекулятивное декодирование показало свою эффективность в снижении задержки путем использования быстрой черновой модели для генерации нескольких токенов, проверяемых параллельно основной LLM. Однако его эффективность в увеличении пропускной способности, особенно при больших размерах пакетов, была подвергнута сомнению.

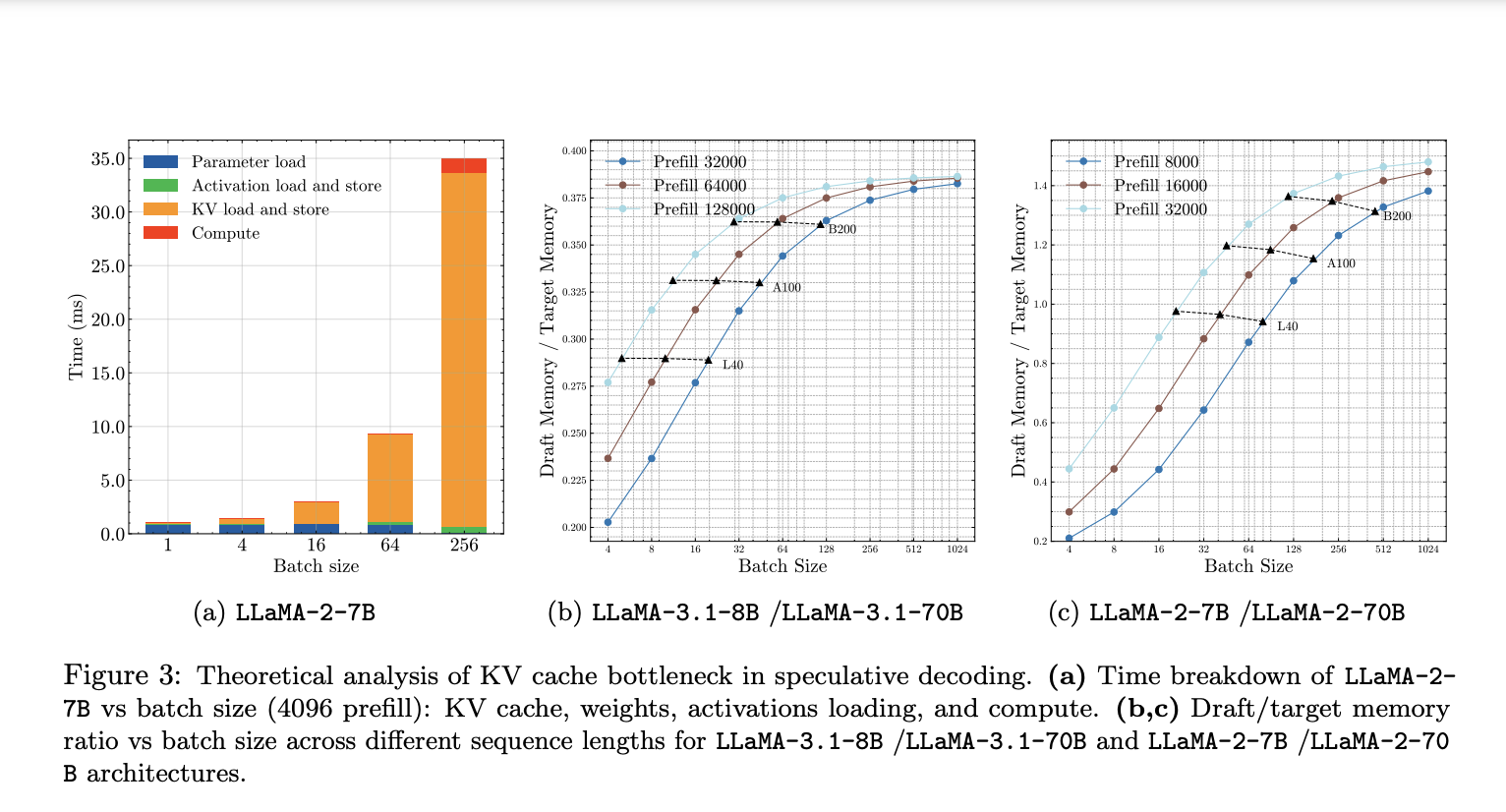

MagicDec, разработанный исследователями из Университета Карнеги-Меллон, Moffett AI и Meta AI, предлагает новый подход к развертыванию спекулятивного декодирования для высокопропускной вывода. Метод основан на тщательном анализе того, как сдвигаются узкие места при увеличении размера пакета и длины последовательности. Для умеренных и длинных последовательностей исследователи обнаружили, что декодирование LLM остается ограниченным по памяти даже при больших размерах пакетов, и ключевое значение имеет кэш ключ-значение (KV). В отличие от загрузки параметров модели, это узкое место масштабируется с размером пакета, что делает спекулятивное декодирование потенциально еще более эффективным для больших пакетов.

На основе этих исследований MagicDec вводит два ключевых нововведения. Во-первых, он использует интеллектуальную стратегию чернового декодирования, способную улучшать скорость с увеличением размера пакета. Это противоречит традиционным подходам, сокращающим длину спекуляции при увеличении размера пакета. Во-вторых, MagicDec решает узкое место KV-кэша с помощью черновых моделей с разреженным KV-кэшем. Этот подход особенно эффективен, потому что размер кэша KV, а не веса модели, становится наиболее важным фактором в режиме больших пакетов и длинных последовательностей.

Производительность MagicDec впечатляет. Для умеренных и длинных последовательностей исследователи продемонстрировали ускорение до 2 раз для модели LLaMA-2-7B-32K и ускорение до 1,84 раз для LLaMA-3.1-8B при обслуживании размеров пакетов от 32 до 256 на 8 графических процессорах NVIDIA A100. Эти результаты показывают, что MagicDec может одновременно улучшать пропускную способность и снижать задержку без ущерба для точности, особенно для длинных последовательностей.

Выводы этого исследования не просто значимы, они переворачивают игру в области обслуживания LLM. Оспаривая традиционное убеждение в том, что спекулятивное декодирование неэффективно для увеличения пропускной способности, MagicDec открывает новые возможности для оптимизации вывода LLM. Способность метода улучшать производительность при различных размерах пакетов и длинах последовательностей делает его особенно ценным в условиях все более распространенных приложений с долгим контекстом.

MagicDec представляет собой значительный шаг вперед в эффективном решении проблем обслуживания больших языковых моделей. Демонстрируя, что возможно преодолеть компромисс между задержкой и пропускной способностью для генерации долгого контекста, это исследование прокладывает путь к более эффективным и масштабируемым приложениям LLM. По мере роста спроса на высокопроизводительное обслуживание LLM, методы, подобные MagicDec, будут критически важны для широкого внедрения этих мощных моделей в различные сферы применения.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу 49 тыс. подписчиков в SubReddit по машинному обучению.

Найдите предстоящие вебинары по ИИ здесь.

Статья MagicDec: Unlocking Up to 2x Speedup in LLaMA Models for Long-Context Applications впервые появилась на MarkTechPost.

Применение ИИ для вашего бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте MagicDec: Unlocking Up to 2x Speedup in LLaMA Models for Long-Context Applications.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь, какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На основе полученных данных и опыта расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram.

Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/. Этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.

«`