«`html

DeepSeek-V2.5: Новая версия модели с 238 миллиардами параметров и возможностью микса экспертов

DeepSeek-AI выпустила DeepSeek-V2.5 – мощную модель Mixture of Experts (MOE) с 238 миллиардами параметров, включающую 160 экспертов и 16 миллиардов активных параметров для оптимизированной производительности. Модель отлично справляется с задачами чата и кодирования, обладая передовыми возможностями, такими как вызовы функций, генерация JSON-вывода и завершение Fill-in-the-Middle (FIM). С впечатляющей длиной контекста в 128 тысяч символов, DeepSeek-V2.5 разработана для обработки обширных и сложных входных данных, выходя за рамки AI-решений.

Эволюция DeepSeek

С момента своего появления DeepSeek-AI известна производством мощных моделей, созданных для удовлетворения растущих потребностей как разработчиков, так и неразработчиков. Серия DeepSeek-V2, в частности, стала универсальным решением для сложных задач искусственного интеллекта, объединяя функциональность чата и кодирования с передовыми техниками глубокого обучения.

Основные особенности DeepSeek-V2.5

Улучшенное соответствие с предпочтениями человека: DeepSeek-V2.5 сосредоточена на лучшем соответствии с предпочтениями человека. Модель оптимизирована для более точного выполнения инструкций и предоставления более релевантных и последовательных ответов. Это улучшение особенно важно для бизнеса и разработчиков, которым требуются надежные AI-решения, способные адаптироваться к конкретным требованиям с минимальным вмешательством.

Улучшенные навыки написания и следования инструкциям: DeepSeek-V2.5 предлагает улучшения в написании, генерации более естественно звучащего текста и более эффективного следования сложным инструкциям по сравнению с предыдущими версиями. Независимо от использования в интерфейсах на основе чата или для генерации обширных инструкций по кодированию, эта модель предоставляет пользователям надежное AI-решение, способное легко справляться с различными задачами.

Общие и кодовые возможности: Объединяя возможности DeepSeekV2-Chat и DeepSeek-Coder-V2-Instruct, модель сокращает разрыв между разговорным AI и помощью в кодировании. Эта интеграция означает, что DeepSeek-V2.5 может использоваться для задач общего назначения, таких как автоматизация обслуживания клиентов, и более специализированных функций, таких как генерация кода и отладка.

Оптимизированные требования к выводу: Для локального запуска DeepSeek-V2.5 требуются значительные вычислительные ресурсы, поскольку модель использует 236 миллиардов параметров в формате BF16, требуя 80 ГБ*8 ГПУ. Однако модель обеспечивает высокую производительность с впечатляющей скоростью и точностью для тех, у кого есть необходимое оборудование. Для пользователей, у которых нет доступа к таким продвинутым настройкам, DeepSeek-V2.5 также может быть запущена через Hugging Face’s Transformers или vLLM, которые оба предлагают облачные решения вывода.

Метрики производительности

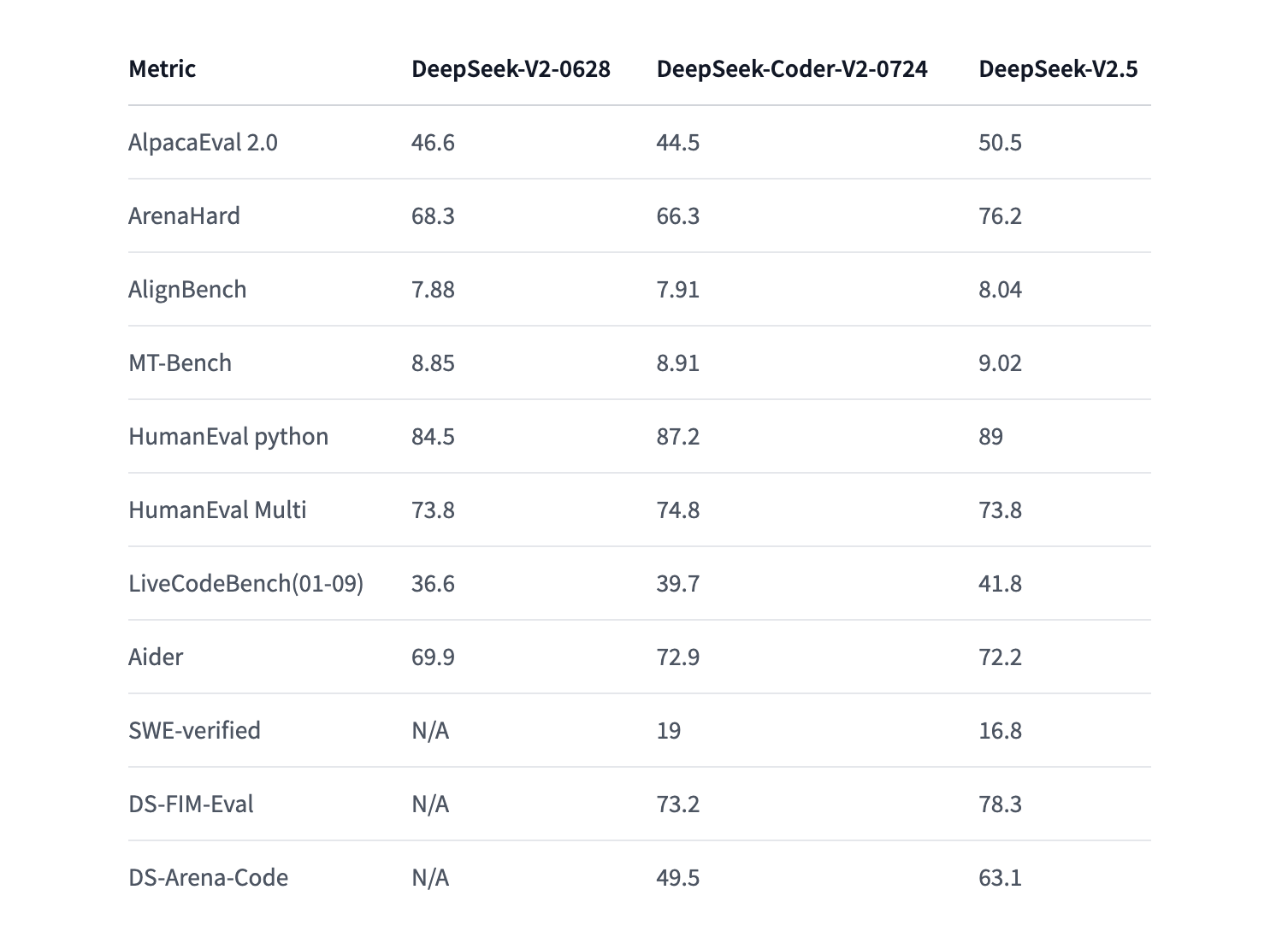

Улучшения в DeepSeek-V2.5 отражаются в его производственных метриках по различным бенчмаркам. На AlpacaEval 2.0 DeepSeek-V2.5 набрала 50.5, по сравнению с 46.6 в модели DeepSeek-V2. Аналогично, в тесте HumanEval Python модель улучшила свой показатель с 84.5 до 89. Эти метрики свидетельствуют о значительных усовершенствованиях в общих навыках рассуждения, навыках кодирования и ответах, соответствующих человеку.

Помимо этих бенчмарков, модель также успешно прошла оценки ArenaHard и MT-Bench, демонстрируя свою универсальность и способность адаптироваться к различным задачам и вызовам. Эти улучшения переносятся на конкретные выгоды для пользователя, особенно в отраслях, где важны точность, надежность и адаптивность.

Вывод и использование

DeepSeek-AI предоставляет несколько способов для пользователей, чтобы воспользоваться DeepSeek-V2.5. Для тех, кто хочет запустить модель локально, Hugging Face’s Transformers предлагает простой способ интеграции модели в их рабочий процесс. Пользователи могут легко загрузить модель и токенизатор, обеспечивая совместимость с существующей инфраструктурой. Также доступна возможность генерации ответов через библиотеку vLLM, что позволяет более быстрый вывод и более эффективное использование ресурсов, особенно в распределенных средах.

DeepSeek-V2.5 обладает возможностями вызова функций, что позволяет взаимодействовать с внешними инструментами для улучшения общей функциональности. Эта функция полезна для разработчиков, которым необходимо, чтобы модель выполняла задачи, такие как получение текущих метеоданных или выполнение вызовов API.

Лицензирование и коммерческое использование

Одним из ключевых аспектов DeepSeek-V2.5 является ее лицензия MIT, которая позволяет гибкое использование как в коммерческих, так и в некоммерческих приложениях. Эта лицензионная модель гарантирует, что бизнесы и разработчики могут интегрировать DeepSeek-V2.5 в свои продукты и услуги, не беспокоясь о ограничительных условиях. Соглашение о модели серии DeepSeek-V2 поддерживает коммерческое использование, что еще больше усиливает ее привлекательность для организаций, стремящихся использовать передовые решения искусственного интеллекта.

Заключение

С выпуском DeepSeek-V2.5, объединяющей лучшие элементы предыдущих моделей и оптимизирующей их для более широкого спектра применений, DeepSeek-V2.5 готова стать ключевым игроком в области искусственного интеллекта. Будь то для задач общего назначения или высокоспециализированных проектов по кодированию, эта новая модель обещает превосходную производительность, улучшенный пользовательский опыт и большую адаптивность, что делает ее бесценным инструментом для разработчиков, исследователей и бизнеса.

DeepSeek-AI продолжает совершенствовать и расширять свои модели искусственного интеллекта, поэтому DeepSeek-V2.5 представляет собой значительный шаг вперед. Это гарантирует, что пользователи имеют доступ к мощному и гибкому AI-решению, способному удовлетворять постоянно меняющиеся требования современной технологии.

«`