«`html

Понимание неизбежной природы галлюцинаций в больших языковых моделях: призыв к реалистичным ожиданиям и стратегиям управления

Предварительные исследования на больших языковых моделях (LLM) продемонстрировали значительные достижения в связи с повышением свободы и точности в различных задачах, оказывая влияние на секторы здравоохранения и образования. Этот прогресс вызвал интерес к способностям LLM в понимании языка и связанным рискам. Галлюцинации, определенные как правдоподобная, но неверная информация, созданная моделями, выдвинулись в качестве центральной проблемы. Исследования исследовали, могут ли эти ошибки быть устранены или требуют управления, признавая их как неотъемлемое вызов LLM.

Практические решения и ценность

Последние достижения в LLM революционизировали обработку естественного языка, но постоянная проблема галлюцинаций требует более глубокого изучения их фундаментальной природы и последствий. Исследование предлагает концепцию «Структурных галлюцинаций», вытекающую из вычислительной теории и Первой теоремы Геделя о неполноте. Эта новая перспектива утверждает, что каждый этап процесса LLM имеет ненулевую вероятность производства галлюцинаций, подчеркивая необходимость нового подхода к управлению этими врожденными ошибками в языковых моделях.

Исследование вызывает сомнения в традиционном взгляде на галлюцинации в LLM, представляя их как неизбежные особенности, а не случайные ошибки. Оно утверждает, что эти неточности происходят из фундаментальных математических и логических основ LLM. Демонстрируя ненулевую вероятность ошибок на каждом этапе процесса LLM, исследование призывает к сдвигу парадигмы в подходе к ограничениям языковых моделей.

Исследователи United We Care предлагают комплексную методологию для решения проблемы галлюцинаций в LLM. Подход начинается с улучшенных техник извлечения информации, таких как провокация цепочки мыслей и усиленная генерация извлечения, для извлечения соответствующих данных из базы данных модели. Этот процесс следует за усилением ввода, объединяя извлеченные документы с исходным запросом для предоставления обоснованного контекста. Затем методология использует методы самоконсистентности во время генерации вывода, позволяя модели производить и выбирать наиболее подходящий ответ из нескольких вариантов.

Послегенерационные техники являются важной частью стратегии, включая количественную оценку неопределенности и генерацию объяснений верности. Эти методы помогают оценить правильность сгенерированных ответов и выявить потенциальные галлюцинации. Использование значений Шепли для измерения верности объяснений улучшает прозрачность и достоверность вывода. Несмотря на эти комплексные меры, исследователи признают, что галлюцинации остаются врожденной характеристикой LLM, подчеркивая необходимость непрерывного развития в управлении этими врожденными ограничениями.

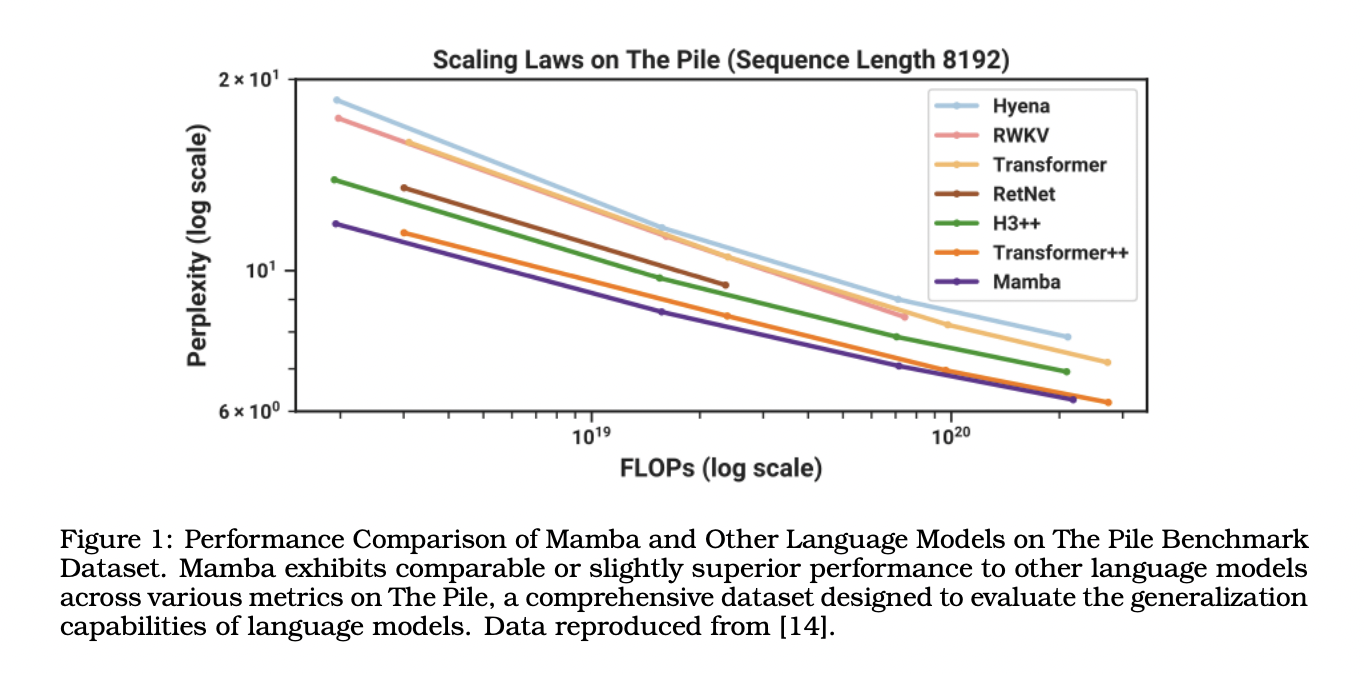

Исследование утверждает, что галлюцинации в LLM являются врожденными и математически определенными, а не просто случайными ошибками. Каждый этап процесса LLM несет ненулевую вероятность производства галлюцинаций, что делает их полное устранение невозможным путем улучшения архитектуры или набора данных. Архитектурные улучшения, такие как трансформаторы и альтернативные модели, такие как KAN, Mamba и Jamba, могут улучшить обучение, но не решают фундаментальную проблему галлюцинаций. В статье утверждается, что производительность LLM, включая их способность точно извлекать и генерировать информацию, по своей сути ограничена их структурным дизайном. Хотя конкретные числовые результаты не предоставляются, исследование подчеркивает, что улучшения архитектуры или обучающих данных не могут изменить вероятностную природу галлюцинаций. Это исследование подчеркивает необходимость реалистичного понимания возможностей и ограничений LLM.

В заключение, исследование утверждает, что галлюцинации в LLM являются врожденными и неустранимыми, сохраняясь несмотря на успехи в обучении, архитектуре или механизмах проверки фактов. Каждый этап генерации вывода LLM подвержен галлюцинациям, подчеркивая системный характер этой проблемы. Основываясь на концепциях вычислительной теории, статья утверждает, что некоторые проблемы, связанные с LLM, являются неразрешимыми, подтверждая невозможность полной точности. Авторы вызывают сомнения в преобладающих убеждениях относительно смягчения галлюцинаций, призывая к реалистичным ожиданиям и сдвигу в направлении управления, а не устранения этих врожденных ограничений в LLM.

Практические применения

Если ваша компания хочет оставаться в числе лидеров с помощью искусственного интеллекта (ИИ), обратите внимание на решение «Understanding the Inevitable Nature of Hallucinations in Large Language Models: A Call for Realistic Expectations and Management Strategies». Это позволит вам понять риски и преимущества применения ИИ в вашем бизнесе.

Проанализируйте, как ИИ может оптимизировать вашу работу и где можно внедрить автоматизацию. Определите ключевые показатели эффективности, которые вы хотите улучшить с помощью ИИ.

Выбирайте подходящее решение, внедряя ИИ постепенно с анализом результатов. Расширяйте автоматизацию на основе данных и опыта.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram.

Попробуйте ИИ ассистент в продажах от Flycode.ru. Этот ИИ ассистент помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.

«`