Практические решения для верификации RDF троек с использованием LLM

В недавних исследованиях была представлена передовая техника использования крупных языковых моделей (LLM) для проверки RDF-троек, подчеркивая важность обеспечения прослеживаемого и проверяемого рассуждения. Основные строительные блоки графов знаний (KGs) — это RDF-тройки, состоящие из утверждений субъект-предикат-объект, описывающих отношения или факты. Сохранение правильности этих утверждений существенно для обеспечения надежности KGs, особенно по мере их применения в различных отраслях, включая бионауки.

Проблема и ее решение

Основной недостаток существующих LLM заключается в их неспособности точно указать источник данных, которые они используют для создания ответов. Предложенный подход умело избегает использования внутренних фактических знаний LLM, предпочитая более строгий метод сравнения соответствующих разделов внешних текстов с тройками RDF, требующими проверки.

Практическое применение

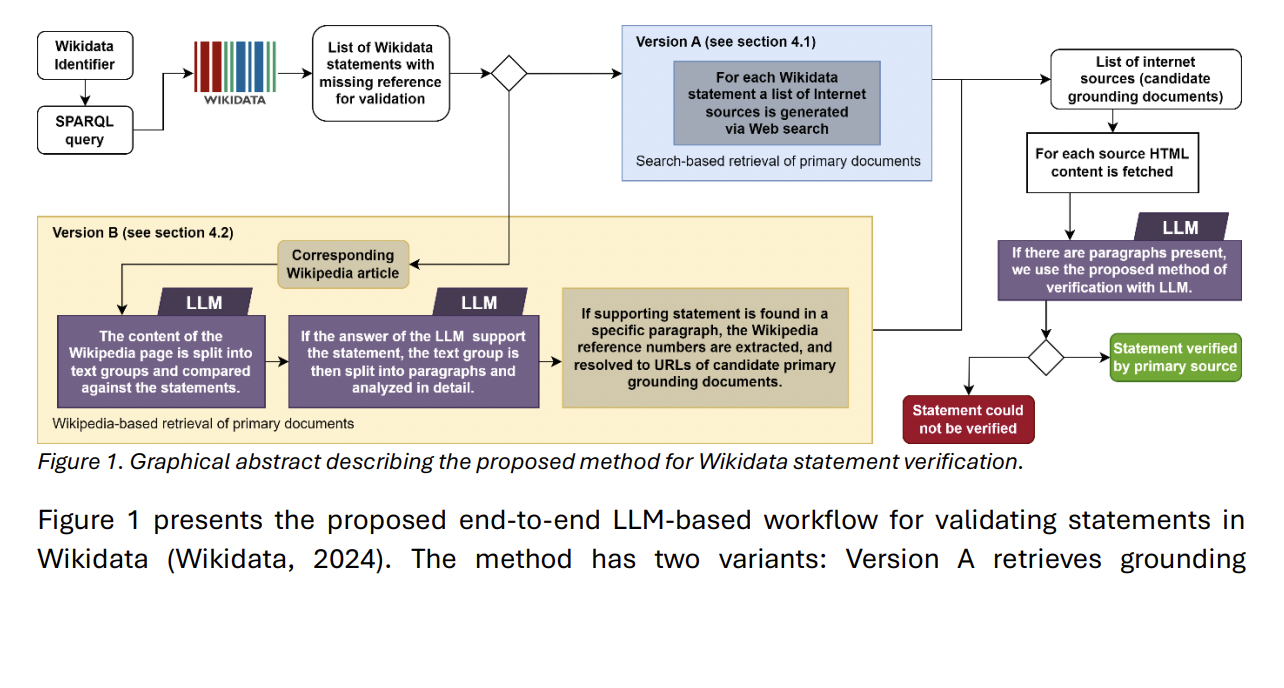

Предложенный метод успешно применялся на одном из крупнейших и популярных графов знаний, Wikidata. Ученые автоматически извлекли RDF-тройки, которые требовалось проверить, из Wikidata с помощью SPARQL-запроса. Они проверили утверждения по внешним документам, подчеркивая потенциал метода для широкого использования.

Заключение

Этот подход представляет собой масштабное средство сохранения точности и надежности KGs путем автоматизации процесса проверки и привязки его к верифицируемым внешним источникам. Человеческий контроль по-прежнему необходим, особенно в ситуациях, когда воспоминания LLM недостаточны. Этот метод является положительным шагом в использовании потенциала LLM для верификации знаний с возможностью прослеживания.