Улучшение возможностей LLM с помощью CodePMP

Большие языковые модели (LLM) значительно продвинулись в понимании и генерации естественного языка благодаря масштабируемым методам предварительного обучения и донастройки. Однако основной вызов заключается в улучшении способностей LLM к рассуждениям, особенно в сложных логических и математических задачах. Недостаток высококачественных данных предпочтений для донастройки моделей вознаграждения (RMs) ограничивает эффективность подходов к обучению с подкреплением на основе обратной связи от людей (RLHF), необходимых для улучшения производительности LLM в рассуждениях. Этот недостаток данных, собирание которых является дорогостоящим и трудоемким процессом, затрудняет масштабирование RMs, создавая критическое узкое место для развития возможностей LLM в задачах рассуждения, таких как решение проблем и принятие решений.

Практические решения:

Исследователи Университета Китайской академии наук представили CodePMP, новый метод предварительного обучения, который генерирует масштабные данные предпочтений из общедоступного исходного кода, специально разработанные для задач рассуждений. Этот инновационный подход позволяет автоматизировать генерацию данных предпочтений, значительно улучшая эффективность и масштабируемость донастройки RM. CodePMP позволяет моделям лучше обобщать задачи рассуждения, предоставляя экономически эффективное решение, которое снижает зависимость от данных, аннотированных людьми.

Ключевые компоненты CodePMP:

Система включает в себя моделирование вознаграждения (RM) и моделирование языка (LM). В RM модель обучается на парах код-предпочтения, учась ранжировать ответы высокого качества выше ответов низкого качества с использованием потерь попарного ранжирования. Компонент LM фокусируется на обучении только выбранных ответов, обеспечивая сохранение общих способностей понимания языка моделью, улучшая при этом ее производительность в рассуждениях.

Результаты и преимущества:

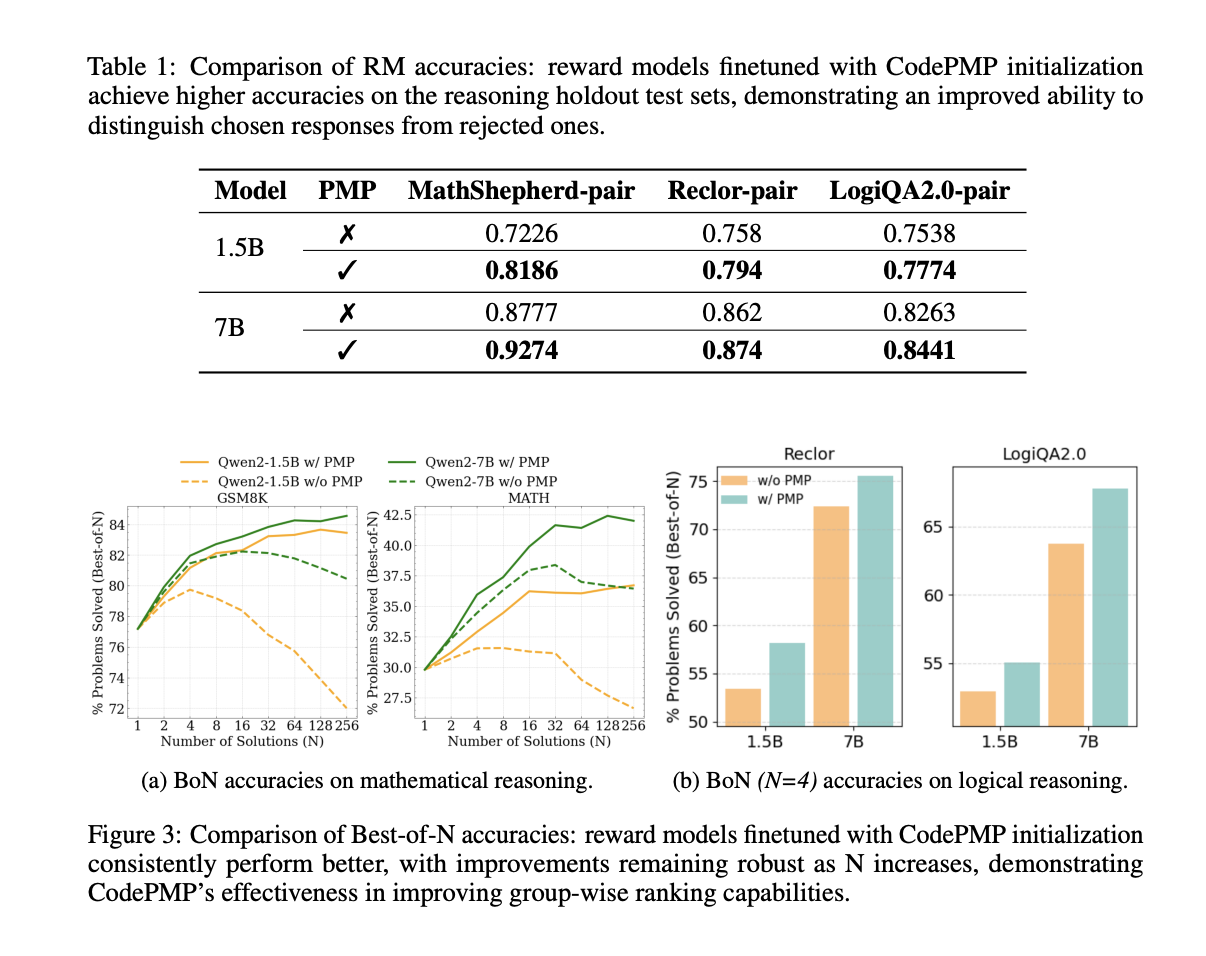

CodePMP продемонстрировал значительное улучшение производительности в рассуждениях по математическим и логическим задачам. Модели, предварительно обученные с использованием CodePMP, последовательно превосходили те, которые были обучены без него, как по точности RM, так и по Best-of-N производительности. Эти улучшения наблюдались как для моделей размером 1,5 млрд, так и для 7 млрд. CodePMP представляет собой масштабное и эффективное решение для улучшения способностей рассуждения в больших языковых моделях, что позволяет им лучше обобщать и производить в различных областях рассуждения.