Проблемы и решения в использовании больших языковых моделей (LLMs)

С увеличением использования больших языковых моделей (LLMs) растут и опасения по поводу их уязвимостей. Несмотря на свои возможности, LLMs подвержены различным атакам, которые могут генерировать токсичный контент, раскрывать личную информацию или позволять инъекции команд. Эти уязвимости вызывают серьезные этические проблемы, такие как предвзятость, дезинформация и возможные нарушения конфиденциальности.

Необходимость эффективной стратегии

Существует настоятельная необходимость в эффективной стратегии для решения этих проблем. Традиционно для выявления уязвимостей используется метод «red teaming», который включает стресс-тестирование ИИ-систем путем моделирования атак. Однако предыдущие подходы к автоматизированному «red teaming» часто не могли сбалансировать разнообразие и эффективность генерируемых атак.

Новый подход OpenAI

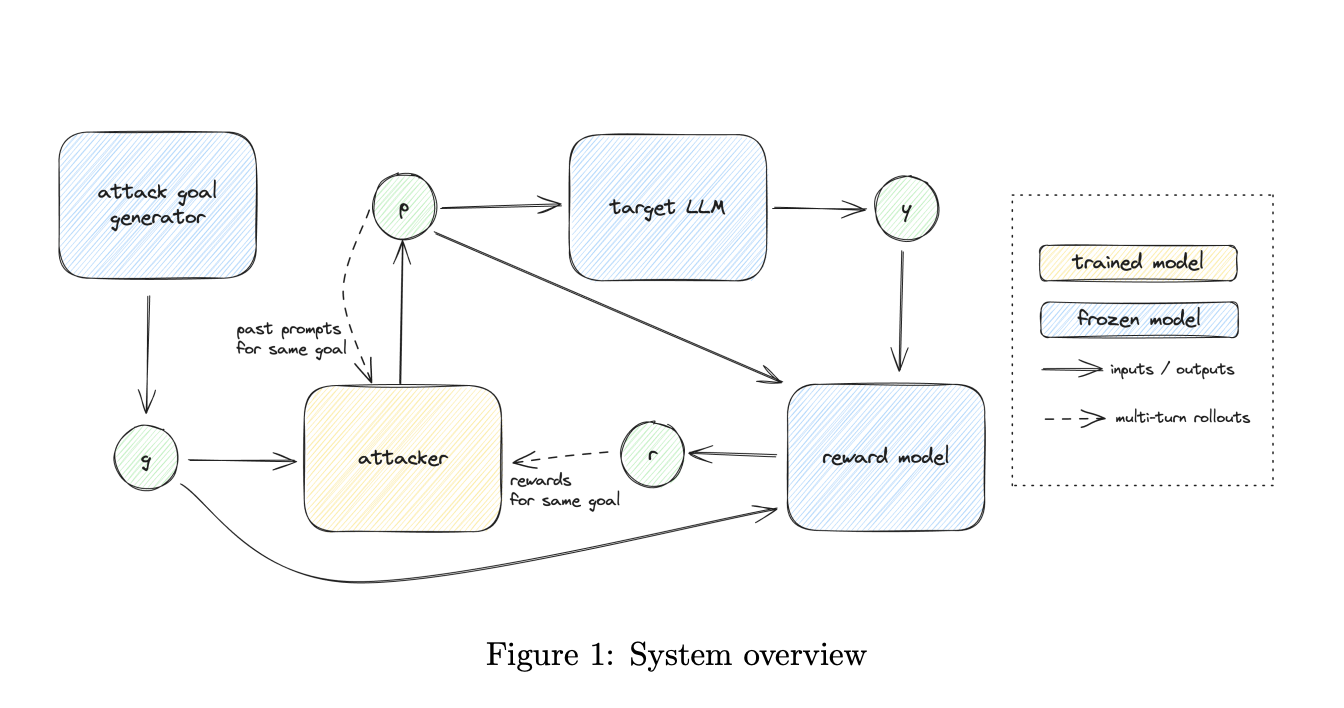

Исследователи OpenAI предлагают новый подход к автоматизированному «red teaming», который сочетает в себе разнообразие и эффективность атак. Этот метод разбивает процесс на два этапа:

- Генерация разнообразных целей для атакующих.

- Обучение атакующего с использованием методов обучения с подкреплением (RL) для достижения этих целей.

Технические детали

Команда исследователей описывает разбиение системы «red teaming» на генерацию целей и обучение атак как способ упрощения процесса и достижения надежных результатов. Для генерации целей используются как небольшие примеры, так и существующие наборы данных прошлых атак. Это обеспечивает разнообразие и конкретные направления для оптимизации атакующего.

Преимущества нового метода

Предложенный метод позволяет генерировать атаки с высокой эффективностью и разнообразием. Исследования показали, что новый подход улучшает результаты по сравнению с предыдущими методами, достигая успеха атак до 50% и значительно увеличивая разнообразие генерируемых примеров.

Заключение

Предложенный подход к «red teaming» открывает новые возможности для автоматизированного тестирования LLMs, устраняя предыдущие ограничения, связанные с компромиссами между разнообразием и эффективностью атак. Это важный шаг к созданию более безопасных и надежных моделей.

Как внедрить ИИ в вашу компанию

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее решение из множества доступных вариантов ИИ.

- Внедряйте ИИ постепенно, начиная с небольших проектов и анализируя результаты.

Получите помощь

Если вам нужны советы по внедрению ИИ, пишите нам. Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.