Роль Red Teaming в оценке рисков ИИ

Red teaming играет важную роль в оценке рисков, связанных с моделями и системами ИИ. Он выявляет новые угрозы, определяет недостатки в текущих мерах безопасности и укрепляет количественные показатели безопасности. Это способствует разработке новых стандартов безопасности, что повышает доверие общества и легитимность оценок рисков ИИ.

Подход OpenAI к внешнему Red Teaming

В этой статье описывается подход OpenAI к внешнему red teaming, подчеркивая его роль в оценке и снижении рисков в современных моделях ИИ. Сотрудничая с экспертами, OpenAI получает ценные данные о возможностях и уязвимостях моделей. Хотя акцент сделан на практике OpenAI, изложенные принципы могут быть полезны и для других организаций.

Ценность внешнего Red Teaming

Внешний red teaming предлагает значительную ценность, выявляя критические аспекты оценки рисков и безопасности ИИ. Он находит новые риски, такие как непреднамеренные поведения, возникающие из-за улучшений в возможностях моделей. Также он тестирует существующие меры защиты, выявляя уязвимости.

Методы Red Teaming

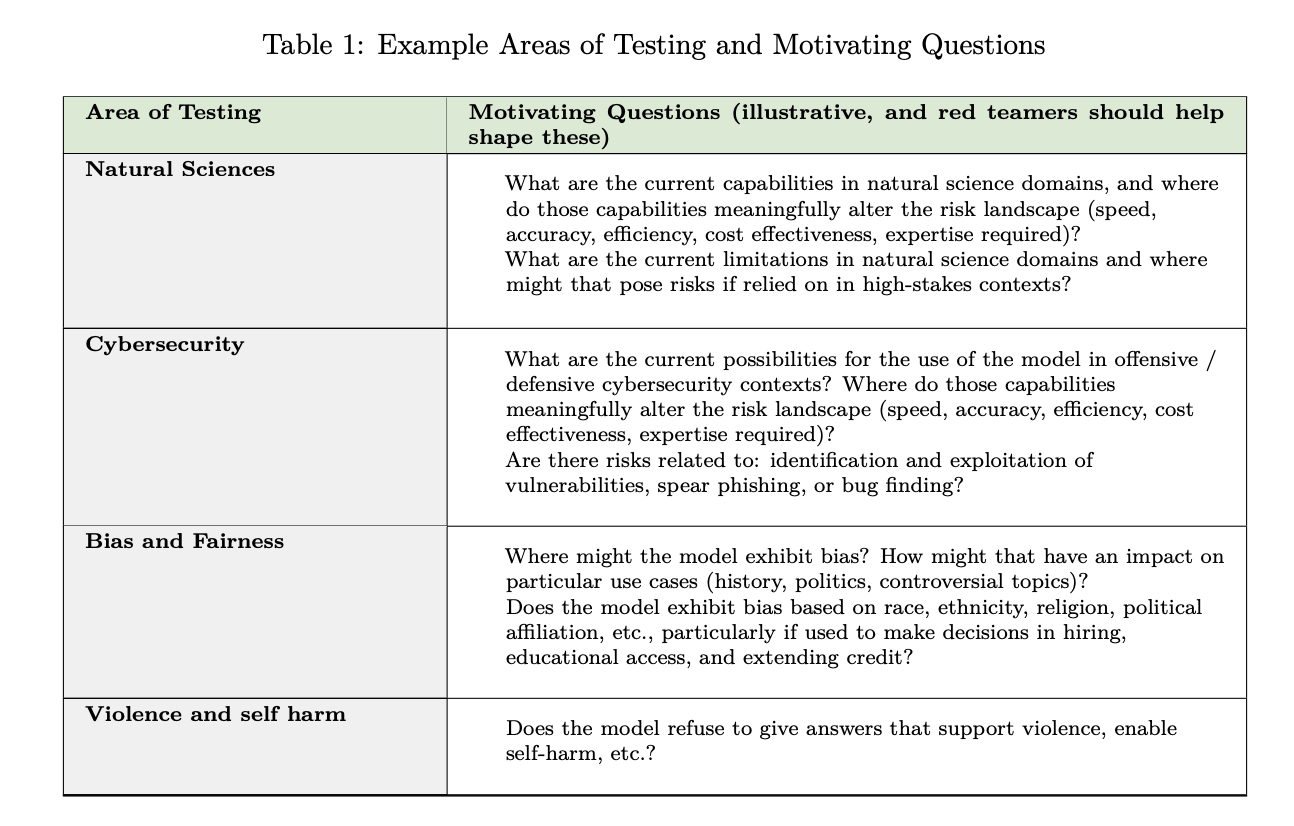

Практики red teaming варьируются, включая ручные методы, где эксперты создают противодействующие запросы, и автоматизированные техники, использующие ИИ для систематической оценки. OpenAI применяет эти методы в своих системах, улучшая оценки моделей.

Эффективная кампания Red Teaming

Создание эффективной кампании red teaming требует стратегических решений и структурированных методик. Важные шаги включают определение группы участников, доступных для тестирования, и создание четких инструкций и документации.

Переход к автоматизированным оценкам

Переход от человеческого red teaming к автоматизированным оценкам необходим для масштабируемых и последовательных оценок безопасности ИИ. Данные, полученные от red teamers, могут использоваться для более быстрого и экономичного тестирования.

Ограничения Red Teaming

Хотя red teaming является ценным инструментом, он имеет ограничения. Одной из проблем является актуальность выводов для развивающихся моделей. Также red teaming требует значительных ресурсов, что может быть недоступно для небольших организаций.

Заключение

Внешний red teaming важен для оценки рисков ИИ, особенно с учетом быстрого развития технологий. Это проактивный механизм для выявления рисков и разработки оценок. Однако необходимо продолжать работу по интеграции общественного мнения и установлению мер ответственности.

Как использовать ИИ для развития вашей компании

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить с помощью ИИ.

- Подберите подходящее ИИ-решение.

- Внедряйте ИИ постепенно, начиная с малого проекта.

- На основе полученных данных расширяйте автоматизацию.

Получите советы по внедрению ИИ

Если вам нужны советы по внедрению ИИ, пишите нам.

Попробуйте ИИ ассистент в продажах

Этот ИИ ассистент помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте, как ИИ может изменить ваши процессы

Изучите решения от Flycode.ru для оптимизации ваших бизнес-процессов с помощью ИИ.