«`html

Настройка и дообучение модели Llama 3.2 3B Instruct

В этом руководстве мы покажем, как настроить и провести дообучение модели Llama 3.2 3B Instruct с использованием специального набора данных на Python. В конце вы узнаете, как адаптировать большие языковые модели для задач, связанных с кодом, и получите практическое понимание необходимых инструментов.

Установка необходимых зависимостей

Для начала установим необходимые библиотеки:

!pip install "unsloth[colab-new]" !pip install "git+https://github.com/huggingface/transformers.git" !pip install -U trl !pip install --no-deps trl peft accelerate bitsandbytes !pip install torch torchvision torchaudio triton !pip install xformers

Эти команды установят все нужные библиотеки для работы с моделью Llama 3.2 3B Instruct.

Импорт необходимых модулей

from unsloth import FastLanguageModel from trl import SFTTrainer from transformers import TrainingArguments import torch from datasets import load_dataset

Импортируем классы и функции для обучения модели и загрузки набора данных на Python.

Загрузка набора данных на Python

max_seq_length = 2048

dataset = load_dataset("user/Llama-3.2-Python-Alpaca-143k", split="train")

Задаем максимальную длину последовательности и загружаем настраиваемый набор данных.

Инициализация модели Llama 3.2 3B

model, tokenizer = FastLanguageModel.from_pretrained(

model_name = "unsloth/Llama-3.2-3B-Instruct-bnb-4bit",

max_seq_length = max_seq_length,

load_in_4bit = True

)

Загружаем модель в формате 4-бит для снижения использования памяти.

Настройка LoRA с Unsloth

model = FastLanguageModel.get_peft_model(

model,

r = 16,

lora_alpha = 16,

use_gradient_checkpointing = "unsloth",

max_seq_length = max_seq_length

)

Применяем LoRA для оптимизации модели и использования памяти.

Подключение Google Drive

from google.colab import drive

drive.mount("/content/drive")

Подключаем Google Drive для сохранения результатов обучения.

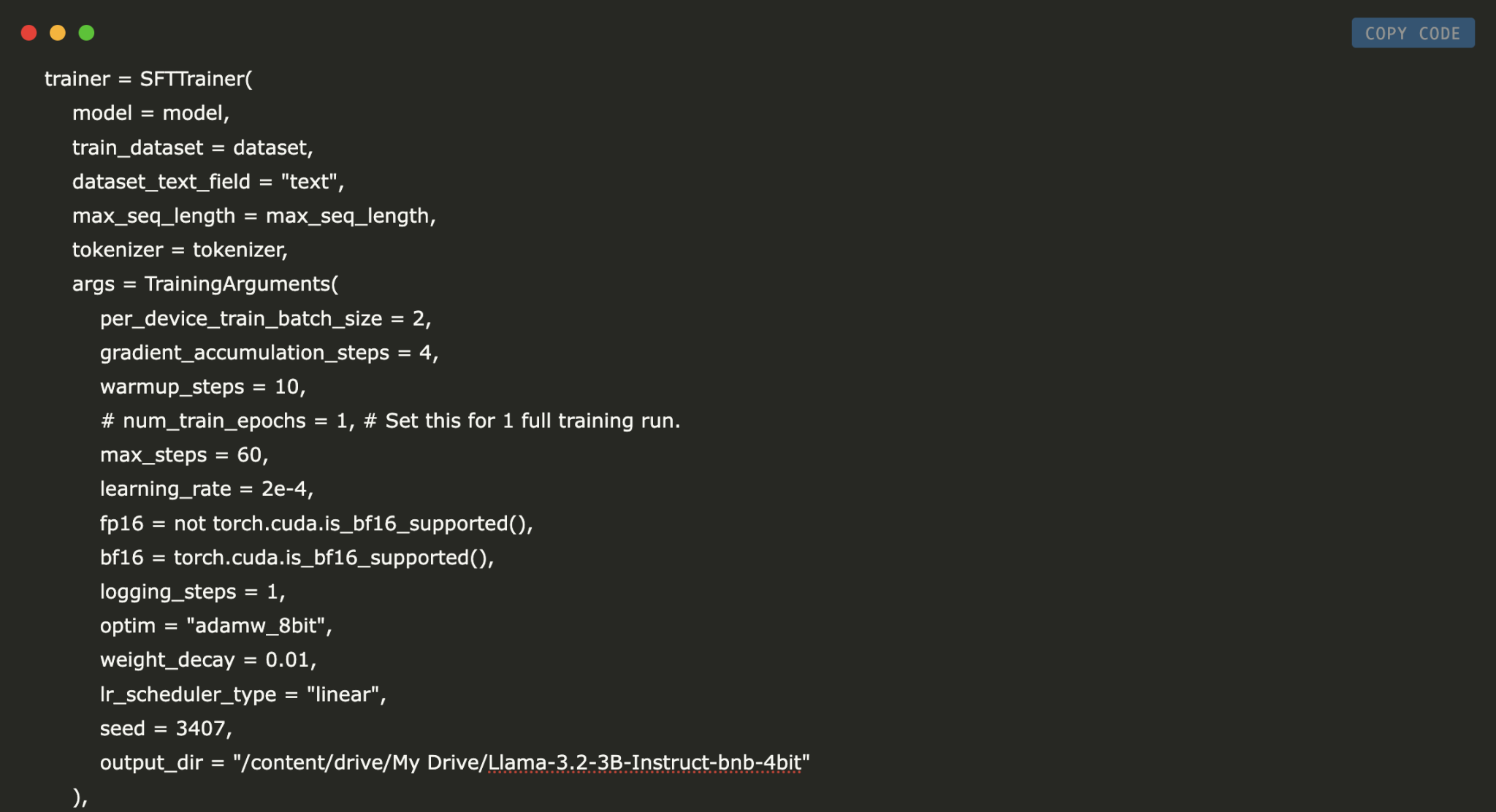

Настройка и запуск цикла обучения

trainer = SFTTrainer(

model = model,

train_dataset = dataset,

max_seq_length = max_seq_length,

args = TrainingArguments(

per_device_train_batch_size = 2,

max_steps = 60,

learning_rate = 2e-4,

output_dir = "/content/drive/My Drive/Llama-3.2-3B-Instruct-bnb-4bit"

),

)

trainer.train()

Создаем экземпляр тренера и запускаем процесс обучения модели.

Сохранение дообученной модели

model.save_pretrained("lora_model")

tokenizer.save_pretrained("lora_model")

Сохраняем дообученную модель и токенизатор для дальнейшего использования.

Заключение

В этом руководстве мы показали, как провести дообучение модели Llama 3.2 3B Instruct с использованием библиотеки Unsloth и LoRA. Используя предоставленные скрипты, вы можете создать более компактную и эффективную модель для работы с Python-кодом.

Ваши шаги к внедрению ИИ

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, важно:

- Проанализировать, как ИИ может изменить вашу работу.

- Определить ключевые показатели эффективности (KPI).

- Подобрать подходящее решение для автоматизации.

- Внедрять ИИ постепенно, начиная с небольших проектов.

Если вам нужны советы по внедрению ИИ, пишите нам.

Попробуйте наш ИИ-ассистент в продажах, который помогает отвечать на вопросы клиентов и генерировать контент.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.

«`