Adam-mini: эффективный оптимизатор, революционизирующий обучение больших языковых моделей с уменьшением использования памяти и улучшением производительности

Исследования в области оптимизации алгоритмов для обучения больших языковых моделей (LLM) являются ключевыми для понимания и генерации человеческого языка. Оптимизация этих процессов является приоритетной задачей для исследователей, учитывая значительные вычислительные ресурсы и память, необходимые для обучения LLM.

Проблема и решение

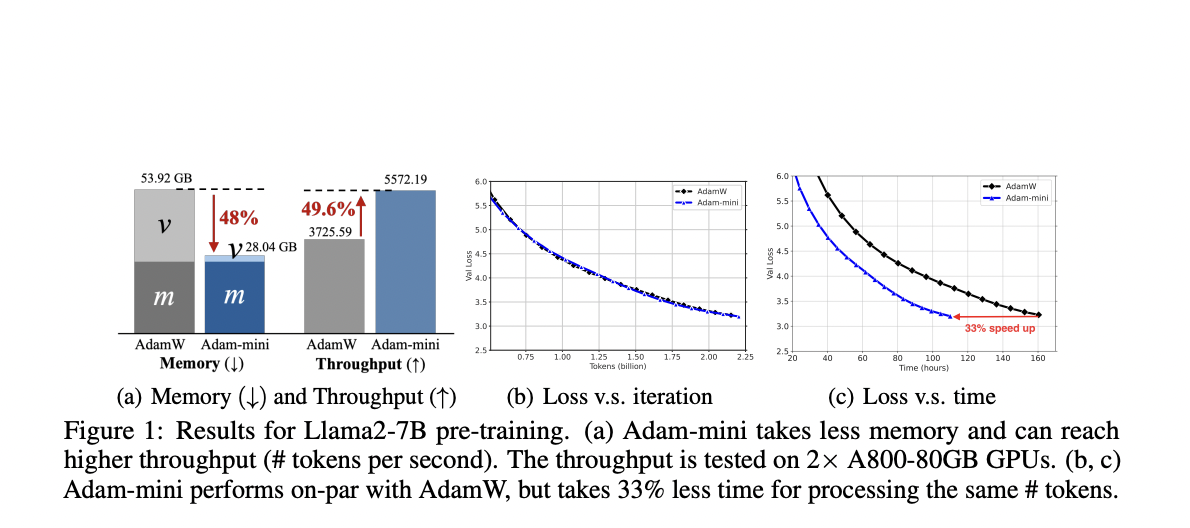

Основная проблема, рассматриваемая в данной статье, — высокий объем памяти, требуемый оптимизационными алгоритмами при обучении больших языковых моделей. Например, оптимизатор Adam требует значительных ресурсов для хранения состояний оптимизатора, что удваивает необходимые ресурсы по сравнению с размером модели. В ответ на это исследователи представили Adam-mini, оптимизатор, разработанный для достижения аналогичной или даже лучшей производительности по сравнению с Adam, с уменьшением использования памяти на 45-50%.

Практические применения

Adam-mini позволяет значительно сократить объем памяти, необходимый для обучения больших моделей, и увеличить производительность. Это ценный инструмент для исследователей, работающих с масштабными языковыми моделями. Уменьшение использования памяти на 50% и увеличение производительности на 50% делает обучение больших моделей более доступным и эффективным.

Если вы хотите узнать больше о внедрении ИИ в ваш бизнес, обращайтесь к нам на Telegram. Также вы можете ознакомиться с ИИ ассистентом в продажах на Flycode.ru, который поможет вам оптимизировать процессы и улучшить взаимодействие с клиентами.