Революция в AI: FastSwitch для обработки сложных нагрузок LLM

Большие языковые модели (LLMs) изменили мир искусственного интеллекта, позволяя выполнять такие задачи, как перевод языков, создание виртуальных ассистентов и генерация кода. Однако для их работы требуется мощная инфраструктура, особенно графические процессоры (GPU), что создает трудности при одновременном обслуживании множества пользователей.

Проблемы и решения

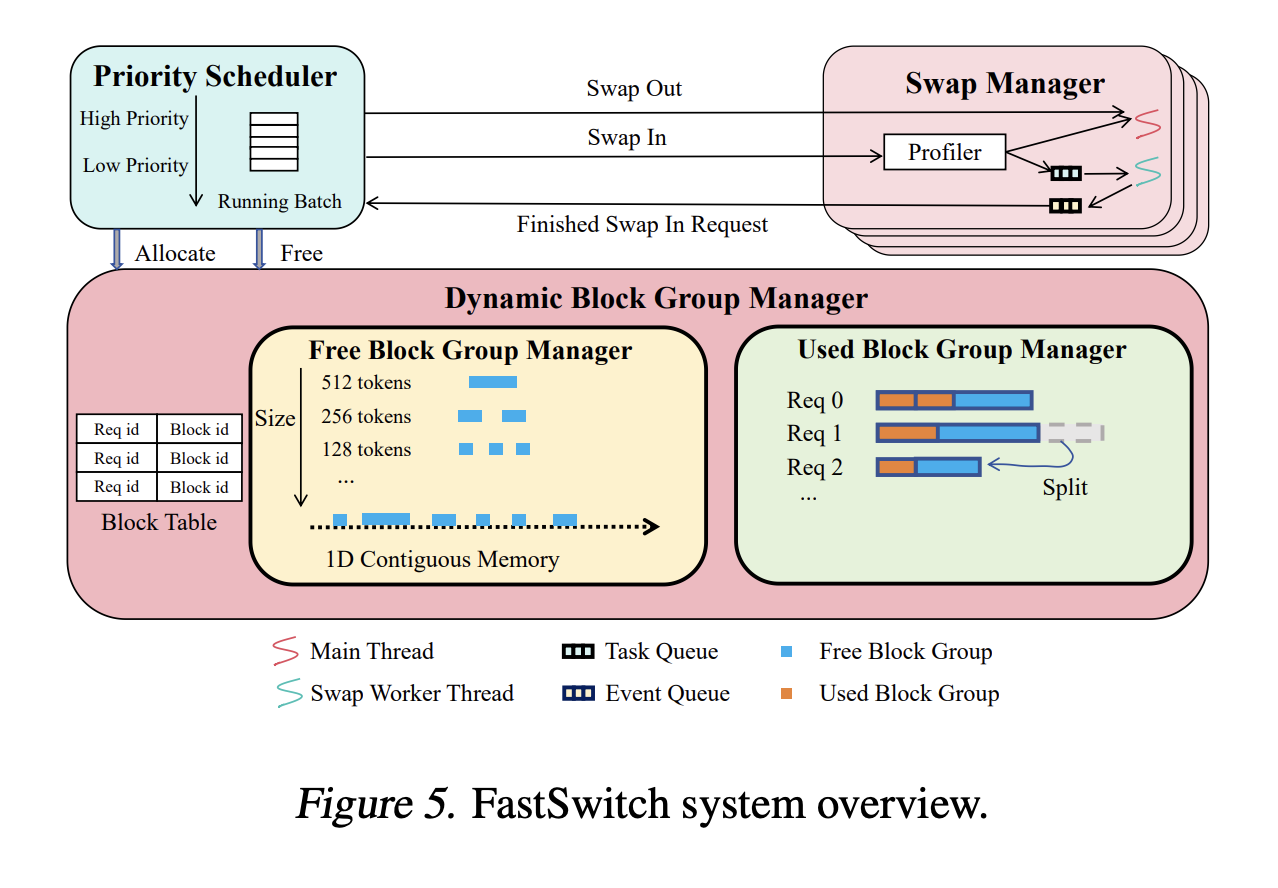

Основная проблема заключается в справедливом распределении ресурсов и поддержании эффективности. Система FastSwitch предлагает три ключевые оптимизации:

- Динамический менеджер блоков: Оптимизирует выделение памяти, группируя блоки, что увеличивает скорость передачи данных.

- Многопоточный менеджер обмена: Увеличивает эффективность генерации токенов, снижая время простоя GPU.

- Механизм повторного использования KV кеша: Снижает задержки, избегая ненужных передач данных.

Преимущества FastSwitch

FastSwitch значительно уменьшает задержки до 3,11 раз по сравнению с существующими решениями и улучшает общую производительность систем LLM:

- Увеличение скорости генерации токенов до 21,8% при P99 задержке.

- Снижение объема обмена блоками на 53% за счет повторного использования кеша.

- Улучшение пропускной способности до 1,44 раз при сложных нагрузках.

Выводы

FastSwitch представляет собой трансформационное решение для современных развертываний LLM. Оно позволяет сбалансировать справедливость и эффективность, обеспечивая высококачественное обслуживание в многопользовательских средах.

Как использовать AI для развития бизнеса

Если вы хотите развивать свою компанию с помощью IA:

- Изучите, как AI может изменить ваши процессы.

- Определите ключевые показатели эффективности (KPI) для улучшения.

- Выберите подходящее AI-решение и внедряйте его постепенно.

Для получения дополнительных советов по внедрению AI, свяжитесь с нами.