«`html

Интеграция нескольких моделей генерации основных моделей помогает объединить сильные стороны моделей, обученных на различных модальностях, таких как текст, речь и изображения, позволяя системе эффективно выполнять кросс-модальные задачи.

Это позволяет эффективно генерировать результаты в нескольких модальностях одновременно, используя специфические возможности каждой модели. Два ключевых вопроса при интеграции нескольких моделей генерации основных моделей — наличие выровненных данных по модальностям и эффективное использование унимодальных представлений в кросс-доменных генеративных задачах без ущерба их первоначальным возможностям.

Архитектура Zipper

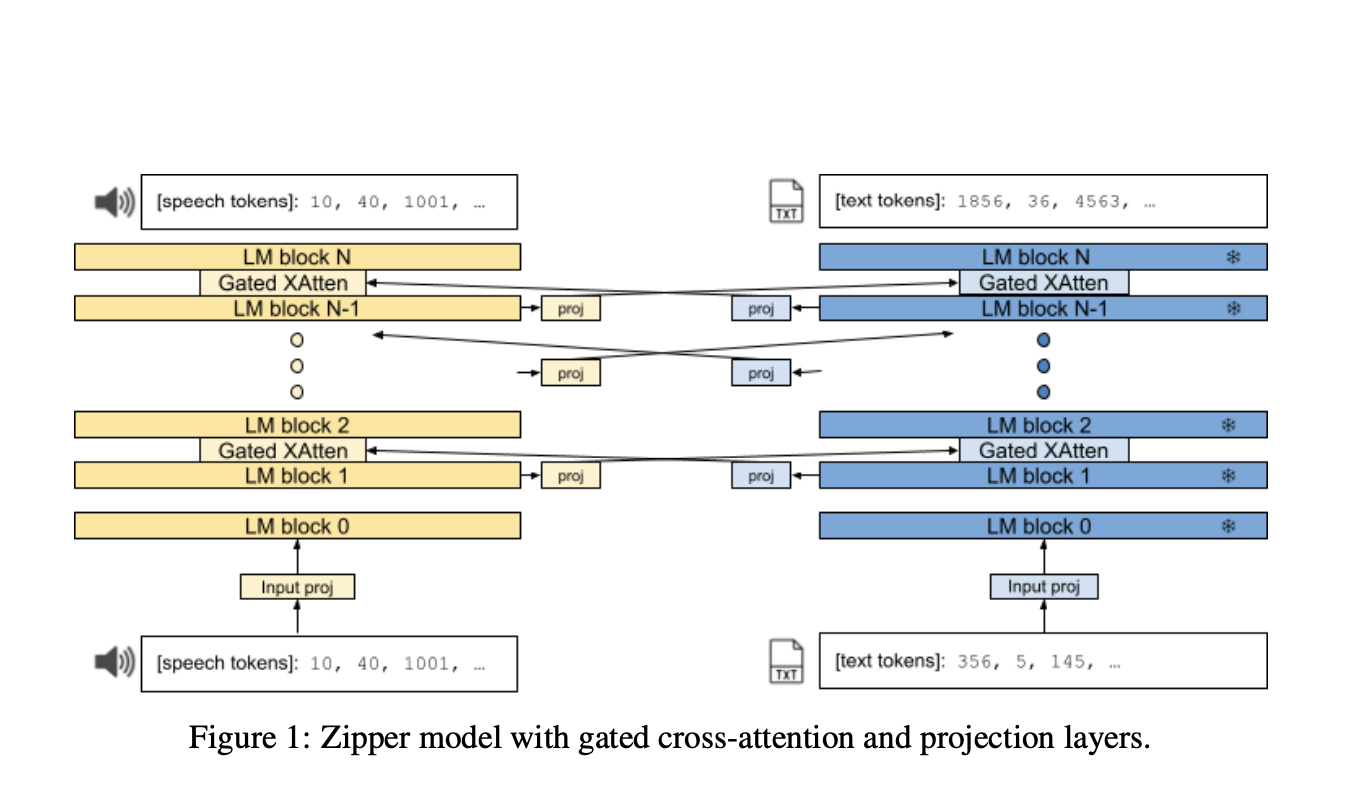

Исследователи Google DeepMind представили Zipper для решения проблемы интеграции нескольких моделей генерации основных моделей, обученных на различных модальностях, в единый фреймворк за пределами простой конкатенации.

Zipper предлагает новое решение, используя независимо предварительно обученные унимодальные декодеры и объединяя их с помощью механизмов кросс-внимания. Этот подход позволяет гибко использовать предварительно обученные декодеры, сохраняя унимодальную производительность.

Эксперименты и результаты

Для оценки предложенной модели исследователи использовали варианты моделей PaLM2 для текстовой основы и аналогичную архитектуру для речевой основы, предварительно обученные с нуля на наборе данных LibriLight. Zipper продемонстрировал конкурентоспособную производительность по сравнению с базовым вариантом, что указывает на его способность сохранять унимодальные возможности и лучшую выравнивающую способность кросс-внимания.

Заключение

Архитектура Zipper предлагает гибкое и масштабируемое решение для интеграции независимо предварительно обученных унимодальных декодеров. Этот подход может продвинуть мультимодельное генеративное моделирование в различных областях и заложить основу для будущих исследований, объединяющих больше модальностей.

«`