SmolLM: новые маленькие модели языка от Hugging Face

Недавно Hugging Face выпустил SmolLM — семейство современных небольших моделей, разработанных для обеспечения мощной производительности в компактной форме. Модели SmolLM доступны в трех размерах: 135M, 360M и 1.7B параметров, что делает их подходящими для различных приложений, обеспечивая при этом эффективность и производительность.

Преимущества SmolLM

Модели SmolLM разработаны для обеспечения высокой производительности при низких вычислительных затратах и улучшенной конфиденциальности пользователей. Они обучены на тщательно подобранном качественном наборе данных SmolLM-Corpus, включающем разнообразные образовательные и синтетические источники данных.

Использование SmolLM

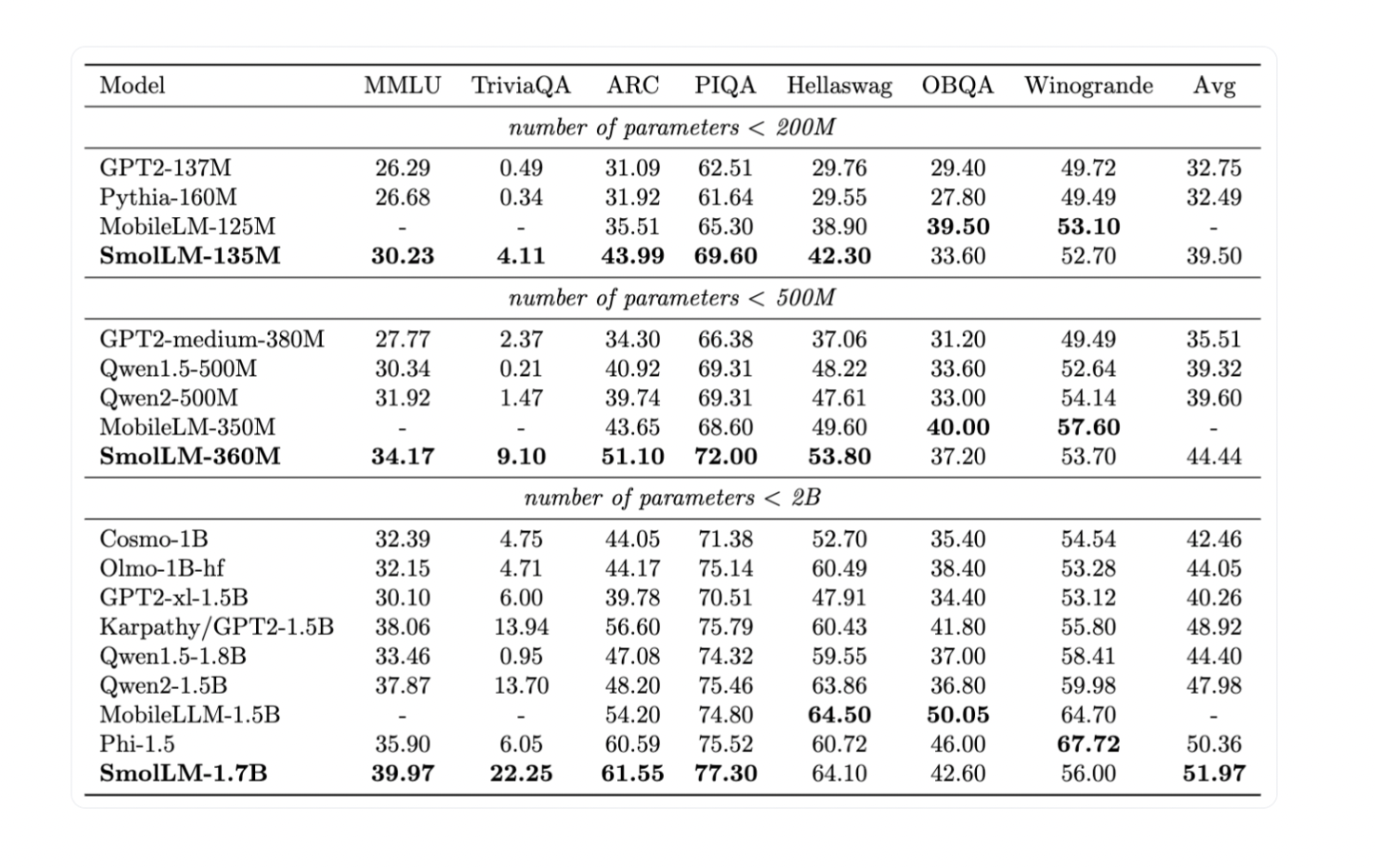

Модели SmolLM построены на наборе данных SmolLM-Corpus, включающем высококачественные источники, такие как Cosmopedia v2, Python-Edu и FineWeb-Edu. Эти модели были оценены на показатели здравого смысла и мировых знаний, продемонстрировав впечатляющую производительность, превзойдя другие модели своего размера.

Эффективность и применение

Одним из значительных преимуществ моделей SmolLM является их способность эффективно работать на различных аппаратных конфигурациях, включая смартфоны и ноутбуки. Это делает их подходящими для применения в различных приложениях, от персональных устройств до более крупных вычислительных систем.

В заключение, Hugging Face успешно продемонстрировал, что высокопроизводительные модели могут быть достигнуты с эффективным обучением на качественных наборах данных, обеспечивая устойчивый баланс между размером модели и производительностью. Модели SmolLM готовы изменить ландшафт малых языковых моделей, предлагая мощные и эффективные решения для различных приложений.