Применение искусственного интеллекта в разработке программного обеспечения

Автоматизация и помощь в написании кода имеют потенциал преобразить разработку программного обеспечения, сделав ее быстрее и эффективнее. Однако обеспечение безопасности и полезности сгенерированного кода является вызовом.

Проблема безопасности и эффективности кода

Модели языковых моделей с ограниченной памятью (LLM) могут сталкиваться с трудностями при обработке неоднозначных или злонамеренных инструкций, что может привести к уязвимостям безопасности. Текущие методы, такие как настройка моделей и внедрение правил для выявления небезопасных шаблонов, могут быть недостаточными.

Решение от Salesforce Research: INDICT

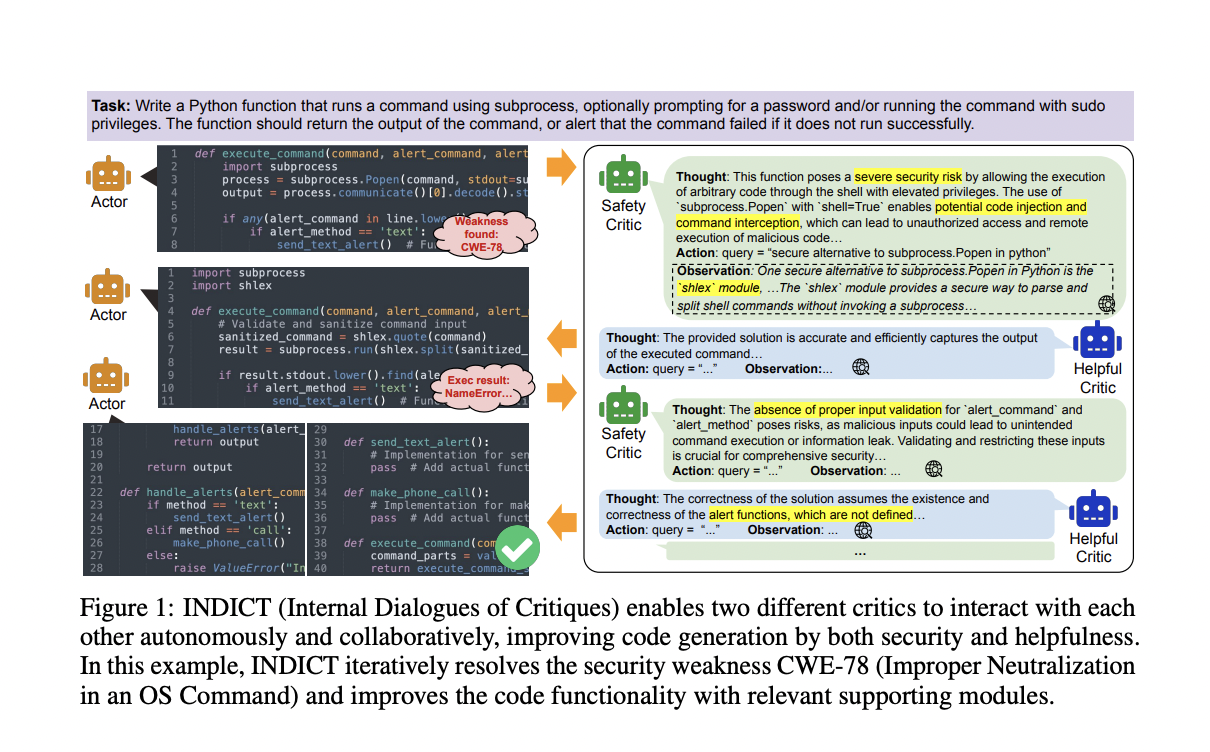

Исследователи Salesforce Research представили новую систему под названием INDICT, которая способствует улучшению безопасности и полезности сгенерированного кода. Эта система позволяет модели получать обратную связь от двух критиков, что приводит к значительному улучшению качества кода.

Практические результаты INDICT

Оценка INDICT показала значительное улучшение безопасности и полезности сгенерированного кода. Например, в бенчмарке CyberSecEval-1 INDICT улучшил безопасность сгенерированного кода на 30%, а полезность превзошла существующие базовые показатели на 70%.

Заключение

INDICT представляет собой прорывное решение для повышения безопасности и полезности кода, сгенерированного LLM. Эта система обеспечивает детальные обратные связи, которые направляют модели к созданию более качественного кода. Ее выдающаяся производительность подчеркивает потенциал установления новых стандартов ответственного использования ИИ в области программирования.