«`html

Развитие больших языковых моделей (LLM)

Разработка больших языковых моделей (LLM) является ключевым направлением в развитии возможностей обработки естественного языка (NLP). Однако обучение этих моделей представляет существенные трудности из-за огромных вычислительных ресурсов и затрат. Наши исследователи постоянно ищут более эффективные методы управления этими требованиями, сохраняя при этом высокую производительность.

Проблема обучения плотных моделей

Критической проблемой в разработке LLM является необходимость обширных ресурсов для обучения плотных моделей. Подход плотных моделей активирует все параметры для каждого входного токена, что приводит к значительным неэффективностям. В результате возникает необходимость в более ресурсоэффективных методах обучения, способных обеспечить конкурентоспособную производительность. Основная цель — достижение баланса между вычислительной осуществимостью и способностью эффективно обрабатывать сложные задачи NLP.

Решение: модели смеси экспертов (MoE)

Традиционно обучение LLM полагалось на плотные, ресурсоемкие модели, несмотря на их высокую производительность. Однако модели смеси экспертов (MoE), такие как Skywork-MoE, представляют собой многообещающую альтернативу. MoE-модели распределяют вычислительные задачи между несколькими специализированными подмоделями или «экспертами». Этот подход может сопоставиться или превзойти производительность плотных моделей, используя лишь долю ресурсов. Эффективность MoE-моделей заключается в их способности активировать только подмножество экспертов для каждого токена, оптимизируя тем самым использование ресурсов.

Преимущества Skywork-MoE

Команда Skywork представила Skywork-MoE — высокопроизводительную MoE-модель с 146 миллиардами параметров и 16 экспертами. Эта модель использует плотные контрольные точки своей предыдущей модели Skywork-13B в качестве начальной настройки. Skywork-MoE включает две новаторские методики обучения: нормализацию логитов ворот и адаптивные коэффициенты вспомогательных потерь. Эти инновации призваны улучшить эффективность и производительность модели. Благодаря использованию плотных контрольных точек модель получает преимущества от существующих данных, что способствует начальной настройке и последующим этапам обучения.

Оценка производительности

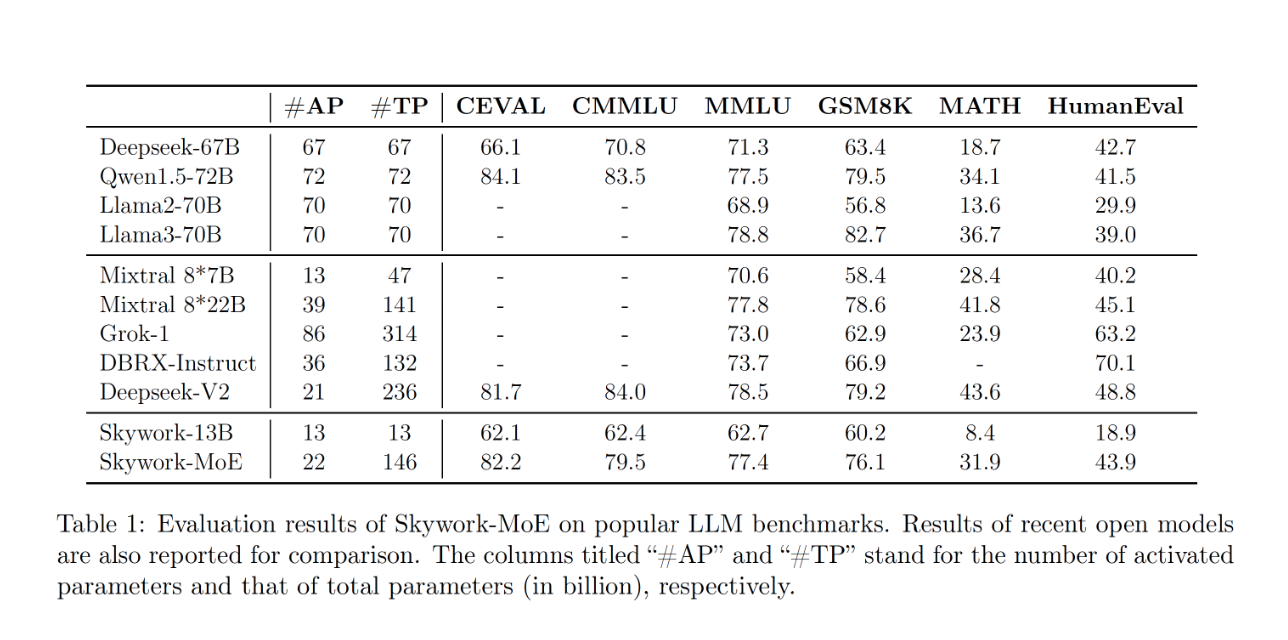

Производительность Skywork-MoE была оценена по различным бенчмаркам. Модель набрала 82,2 балла на бенчмарке CEVAL и 79,5 балла на бенчмарке CMMLU, превзойдя модель Deepseek-67B. На бенчмарке MMLU модель набрала 77,4 балла, что конкурентоспособно по сравнению с более емкими моделями, такими как Qwen1.5-72B. Для задач математического рассуждения Skywork-MoE набрала 76,1 балла на GSM8K и 31,9 балла на MATH, комфортно опередив модели Llama2-70B и Mixtral 8*7B. Модель продемонстрировала надежную производительность в задачах синтеза кода, набрав 43,9 балла на бенчмарке HumanEval, превзойдя все плотные модели и незначительно уступая модели Deepseek-V2. Эти результаты подчеркивают способность модели эффективно обрабатывать сложные задачи квантитативного и логического рассуждения.

Заключение

Команда Skywork успешно решила проблему ресурсоемкого обучения LLM, разработав Skywork-MoE, которая использует инновационные методики для улучшения производительности и снижения вычислительных затрат. Skywork-MoE с 146 миллиардами параметров и передовыми методами обучения представляет собой значительное достижение в области NLP. Превосходная производительность модели по различным бенчмаркам подчеркивает эффективность методик нормализации логитов ворот и адаптивных коэффициентов вспомогательных потерь. Эти исследования конкурируют с существующими моделями и устанавливают новый стандарт эффективности MoE-моделей в задачах обработки языка большого масштаба.

Применение искусственного интеллекта в вашем бизнесе

Если вы хотите использовать искусственный интеллект (ИИ) для развития вашей компании и оставаться в числе лидеров, обратитесь к нам. Мы поможем вам определить возможности применения автоматизации и выбрать подходящее решение. Начните с малого проекта, анализируйте результаты и опыт, постепенно расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/flycodetelegram.

Попробуйте ИИ ассистент в продажах https://flycode.ru/aisales/. Этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от Flycode.ru.

«`